Volume 8, No. 3, Art. 26 – September 2007

Generalisierung in qualitativer Forschung

Philipp Mayring

Zusammenfassung: Im traditionellen Wissenschaftsverständnis sind generalisierte Aussagen zentrales Ziel von Wissenschaft; sie sind Elemente des Theoriebildungsprozesses; aus ihnen werden Prognosen und Anwendungen für die Zukunft abgeleitet. Es gibt zwei Linien der Kritik am Konzept der Generalisierung: Einerseits wird in postpositivistischer Wissenschaftstheorie die prinzipielle Möglichkeit induktiven Schließens, und damit der Generalisierung, bezweifelt (POPPER 1935). Andererseits wird aus konstruktivistischer Sicht das Erkenntnisziel auf kontextspezifische Aussagen beschränkt und wiederum Generalisierung als unmöglich bezeichnet (LINCOLN & GUBA 1985).

Hier wird der Standpunkt vertreten, dass Generalisierung für qualitativ orientierte Forschung besonders wichtig ist, allerdings verschiedene Formen unterschieden werden müssen. Zunächst gilt es zu unterscheiden, worauf hin generalisiert werden soll: sind es Gesetzesaussagen, Regelhaftigkeiten, Gemeinsamkeiten und Unterschiede, kontextspezifische Aussagen oder nur Prozeduren der Erkenntnisgewinnung. Verschiedene Konzepte der Generalisierung stehen dabei zur Verfügung: Gesamterhebungen, Falsifizierungen, verschiedene Stichprobenstrategien, Theoretical Sampling, argumentative Verallgemeinerung, Variation, Triangulation. Das jeweilige Forschungsdesign entscheidet, welche Art der Generalisierung mit Gewinn für qualitativ orientierte Projekte eingesetzt werden kann. Entsprechende Überlegungen werden für qualitative Einzelfallstudien angestellt.

Keywords: Generalisierung, qualitative Forschung, Einzelfallanalyse

Inhaltsverzeichnis

1. Einleitung

2. Die Logik der Generalisierung

3. Kritik der Generalisierung

4. Ziel der Generalisierung

5. Verfahren der Generalisierung

6. Möglichkeiten der Generalisierung von Einzelfallstudien

7. Schlussbemerkungen und Fragen

In qualitativ orientierten Forschungsprojekten kommen in der Regel intensivere und extensivere Erhebungs- und Auswertungsmethoden zum Einsatz wie Tiefeninterviews, offene Fragebögen, langfristig angelegte Feldforschung mit breiten Feldnotizen oder interpretative Dokumentenanalyse. Dies lässt dann oft nur wenig Fälle oder kleine Stichproben zu. Aber können wir nun auch generellere Schlüsse aus unseren Daten ziehen? Gelten die Ergebnisse solch einer Studie nur für den untersuchten Bereich oder auch für den Zielbereich, die Population, über die die Studie Aussagen machen wollte? Finden wir in unseren Fallanalysen oder kleinen Stichproben Charakteristika, die auch für andere Fälle oder Stichproben Gültigkeit haben? Damit ist das Problem der Generalisierung angesprochen. [1]

Gängige Definitionen des Generalisierungsbegriffs enthalten Aspekte wie

den Schluss von spezifischen Fakten auf generelle Aussagen, wissenschaftliche Gesetze;

die Ausweitung der Gültigkeit von Aussagen;

den Transfer von Annahmen über Personen, Situationen oder Kontexte;

das Anheben des Abstraktionsniveaus in Aussagen. [2]

In traditioneller quantitativer Sozialforschung wird das Problem der Generalisierung unter dem Begriff externer Validität (von experimentellen Studien) diskutiert: Kann das gleiche Ergebnis unter unterschiedlichen Bedingungen (in der Alltagssituation statt der Laborsituation) wiedergefunden werden (SARAFINO 2005, S.54)? [3]

Generalisierung stellt einen zentralen Schritt im qualitativ orientierten Forschungsprozess dar, wie FLICK (2005) in seinem Forschungsprozessmodell herausgearbeitet hat. Er unterstreicht die Notwendigkeit, das Ziel der Generalisierung (z.B. Vergleich, Typologie, Situationen, Personen, Geschlecht, Alter) festzulegen. Aber was sind die genauen Vorgehensweisen bei einer Generalisierung? [4]

In seinem Beitrag zur FQS-Debatte über Qualitätsstandards qualitativer Sozialforschung unterstreicht FAHRENBERG (2003) die Notwendigkeit einer Generalisierung und kritisiert gleichzeitig qualitativ orientierte Studien, die vorschnell ihre Ergebnisse verallgemeinern. METCALFE (2005) hat in dieser FQS-Debatte gefordert, dass Forscherinnen und Forscher ihren Ansatz zur Generalisierung ihrer Forschungsergebnisse klären und explizieren sollten. [5]

Einige Autoren und Autorinnen vertreten den Standpunkt, dass die Art der Generalisierung sich in qualitativer und quantitativer Forschung prinzipiell unterscheide. DIRIWÄCHTER, VALSINER und SAUCK (2005) unterscheiden hier zwischen funktionaler Generalisierung (Suche nach Gemeinsamkeiten zwischen verschiedenen Beobachtungen, eher quantitativ) und kategorialer Generalisierung (Bilden homogener Klassen, eher qualitativ). FLICK (2005) differenziert zwischen numerischer und theoretischer Generalisierung, was in eine ähnliche Richtung geht. Sie alle betonen aber die hohe Bedeutung von Verallgemeinerungen auch (bzw. besonders) für qualitative Forschung. [6]

2. Die Logik der Generalisierung

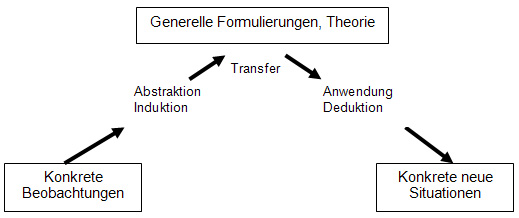

Die Generalisierung der Forschungsergebnisse scheint also ein Kernbereich wissenschaftlicher Arbeit zu sein, ein zentrales Merkmal gesicherten Wissens als Ziel von Wissenschaft. Aus einzelnen Beobachtungen (im weiteren Sinne also auch sprachlichen Daten) wird versucht, allgemeinere Formulierungen abzuleiten, die dann für zukünftige Situationen wieder konkretisiert werden können, wie Abb. 1 illustriert.

Abbildung 1: Der Prozess der Generalisierung [7]

Die Formulierung allgemeinerer, genereller Aussagen wird durch Abstraktion von konkreten "Daten" möglich. Dieser Schluss wird als Induktion bezeichnet. Diese generelleren Formulierungen können mit anderen, vorher entwickelten Allgemeinaussagen zu einem Netzwerk von Aussagen, zu einer Theorie, verbunden werden. Der Vorteil solcher Theorien ist, dass man sie – sofern die Prämissen zutreffen – auf neue, zukünftige Situationen anwenden kann, die man nun nicht mehr neuerlich explorieren muss. Dieser Schluss wird als Deduktion bezeichnet. Ein solches Vorgehen erscheint zentral für wissenschaftliches Arbeiten. Allerdings gibt es Einwände. [8]

Wir können prinzipiell zwei kritische Positionen gegenüber diesem Generalisierungskonzept festmachen: eine konstruktivistische und eine kritisch-rationalistische Position. [9]

Die erste Linie der Kritik kann mit dem bekannten Zitat charakterisiert werden: "The only generalization is that there is no generalization" (LINCOLN & GUBA 1985, S.110). Ohne hier auf Feinheiten und Differenzierungen einzugehen: Vom konstruktivistischen wissenschaftstheoretischen Standpunkt aus werden Phänomene als nur zeit- und kontextspezifisch fassbar angesehen. Erkenntnis kann nur aus der Rekonstruktion subjektiver Perspektiven auf Phänomene in spezifischen Situationen bestehen. So kann das Ziel von Wissenschaft nur die Entwicklung eines idiographischen Wissensbestandes sein. Auch der Sozialkonstruktivismus, der nach Gemeinsamkeiten solcher subjektiver Perspektiven sucht, sieht diese immer als zeit- und kontextspezifisch an. DENZIN (1983) argumentiert in eine ähnliche Richtung, wenn er sagt, "the interpretivist rejects generalization as a goal" (DENZIN 1983, S.133). Menschliche Interaktionen und Phänomene der Lebenswelt haben immer multiple Bedeutungen, was zu einer inhärenten Indeterminiertheit führe und Generalisierungen verbiete. [10]

Die zweite generalisierungskritische Position argumentiert, dass vom Standpunkt der Logik ein vollständiger induktiver Beweis nicht möglich sei (POPPER 1935). Auch wenn wir tausende weißer Schwäne beobachtet haben, können wir nicht daraus schließen, dass alle Schwäne weiß sind, da in Zukunft ein nicht-weißer Schwan beobachtet werden könnte. Nur solche raum-zeitlich unbegrenzten Allaussagen ("Alle Schwäne sind weiß") seien aber wissenschaftlich brauchbar. Deshalb hat POPPER das Verfahren der Falsifikation von Allaussagen als Ziel von Wissenschaft entwickelt, das logisch unproblematisch sei. Auf diese Weise würden nach Falsifikation falscher Allaussagen die richtigen (bisher nicht falsifizierten) übrig bleiben. Diese Position des Kritischen Rationalismus, heute mitunter als Post-Positivismus bezeichnet, findet sich auch innerhalb qualitativ orientierter Forschung (vgl. DENZIN & LINCOLN 2003). [11]

Es gibt auch Positionen, die zwischen den extremen Standpunkten für und gegen Generalisierung vermitteln wollen. Malcom WILLIAMS (2002) bezeichnet sie als "moderatum generalization" und stellt sie in Gegensatz zur "total generalization", bei der der spezifische Satz S komplett und identisch durch das generelle Gesetz abgedeckt ist. "Moderatum generalization: where aspects of S can be seen to be instances of a broader recognizable set of features. This is the form of generalization made in interpretive research" (WILLIAMS 2002, S.131). [12]

Ich möchte hier dafür argumentieren, dass eine solche moderate Position für qualitativ-orientierte Forschung fruchtbar ist. Generalisierung ist wichtig und notwendig für wissenschaftliches Vorgehen, wir müssen jedoch dabei genau bestimmen, auf welche Art von wissenschaftlichen Aussagen wir generalisieren wollen (Abschnitt 4) und mit welchen Prozeduren diese Verallgemeinerung vonstatten gehen soll (Abschnitt 5). [13]

Im zweiten Abschnitt wurde dargelegt, dass allgemeine Aussagen, theoretische Sätze, das Ziel der Generalisierung sind. Diese können jedoch sehr unterschiedliche Formen und Strukturen annehmen, die jeweils verschiedene Prozeduren der Generalisierung bedürfen. Vielleicht kann man acht Klassen von generellen Aussagen und damit Zielen der Generalisierung unterscheiden:

Universelle Gesetzesaussagen, raum-zeitlich unbeschränkt gültig, wie von POPPER gefordert, könnten Ziel der Generalisierung sein, sind aber nicht mit Gewissheit zu belegen (vgl. dazu auch METCALFE 2005). Relativierende Beobachtungen können in der Zukunft jederzeit auftreten, sodass die Generalisierung in einem Prozess permanenter Überprüfung gehalten werden muss. Es sind allerdings Zweifel anzumelden, ob solche universellen Gesetze in den Sozialwissenschaften überhaupt gefunden werden können. In der Psychologie beispielsweise wurden solche Versuche (Frustrations-Aggressions-Gesetz: Menschen, die frustriert werden, reagieren aggressiv; frühe Lerntheorien: klassische und operante Konditionierung) durch nachfolgende Forschung eingeschränkt (bei der Frustrations-Aggressionstheorie durch Berücksichtigung der Ärgeremotionen; in der Lerntheorie durch Berücksichtigung kognitiver Faktoren).

Statistische Gesetzesaussagen sind einfacher zu belegen, weil sie entgegenlaufende Beobachtungen zulassen. Es muss nur gezeigt werden, dass deren Häufigkeit so gering ist, dass dies mit zufälligen Abweichungen erklärt werden kann.

Wenn generelle, theoretische Sätze vorsichtiger formuliert werden sollen, so ist der Regelbegriff sehr hilfreich. Regeln beschreiben Gleichförmigkeiten und Ähnlichkeiten, Regeln können Ausnahmen zulassen. Peter WINCH (1958) war einer der ersten, der den Regelbegriff anstelle des Gesetzesbegriffs in die Sozialwissenschaften eingeführt hat. Menschliche Verhaltensweisen sind bedeutungsvoll und symbolisch vermittelt und so als Anwendung von Regeln im sozialen Kontext zu verstehen.

Weiter eingeschränkt und bescheidener im Generalisierungsziel wäre es, nur auf kontextspezifische Aussagen zu verallgemeinern. Wir versuchen Regeln zu formulieren oder Beziehungen zu beschreiben, die nur unter bestimmten Bedingungen gelten, in ähnlichen Situationen oder Zeiten, für ähnliche Personen. Eine Studie will beispielsweise nur Aussagen für Mittelschichtangehörige zeitgenössischer Industrienationen machen. Das Konzept der Theorien mittlerer Reichweite, auf Robert MERTON (1968) zurückgehend, geht in diese Richtung. METCALFE (2005) verweist hier auf die systemtheoretische Denkweise, die Wissen als gebunden an spezifische Kontextbedingungen ansieht.

Nur Gemeinsamkeiten und Unterschiede im erhobenen Material durch systematische Vergleiche zu suchen, wäre eine wiederum moderate Form der Generalisierung. Hinter den Gemeinsamkeiten und Unterschieden können Regelmäßigkeiten, Variablenzusammenhänge stehen. Dies ist jedoch eine Sache der Interpretation und wird durch die empirischen Daten selbst nicht belegt.

Deskriptive Studien versuchen, eine Basis für Generalisierungen zu liefern, indem sie spezifische Beobachtungen sammeln, aus denen Gemeinsamkeiten und Unterschiede und damit mögliche Variablenzusammenhänge geschlossen werden können. Gute deskriptive Studien präsentieren das zu untersuchende Phänomen in seiner ganzen Breite, explorieren es in verschiedenen Kontexten, um so die Basis für spätere Generalisierungen bereitzustellen.

Explorative Studien generalisieren zwar selbst ebenso wenig wie deskriptive Studien, doch sie versuchen, generelle Sätze als Hypothesen zu formulieren, die dann in nachfolgenden Studien auf ihre Gültigkeit hin überprüft werden (können). Sie sollten dabei reflektieren, wie eine solche Überprüfung vorgenommen werden könnte (z.B. Formulierung empirisch testbarer Hypothesen).

Die "bescheidenste" Form von Generalisierung wäre es, wenn nicht Resultate der Studie verallgemeinert werden sollen, sondern nur die Prozeduren, um zu Resultaten zu kommen. So wird im Rahmen von Aktionsforschung oft formuliert, dass nicht die gefundene Praxisveränderung verallgemeinert werden kann, sondern nur die Art und Weise, wie die Lösung des Praxisproblems angegangen wurde. Vielleicht geht die wissenschaftstheoretische Position des Konstruktivismus in eine ähnliche Richtung: Nicht die Ergebnisse der Rekonstruktionen, sondern nur die Vorgehensweisen, die Diskurse über Realität, können verallgemeinert werden. [14]

Dies acht Ebenen der Generalisierung unterscheiden sich im Grad der Abstraktion: von allgemeingültigen Gesetzen bis zu Prozeduren, um Einsicht in spezifische Situationen zu gewinnen. Welches Generalisierungsziel adäquat ist, hängt ab von der wissenschaftstheoretischen Position des Forschers/der Forscherin, von den Bedingungen und Möglichkeiten des Forschungsfeldes und von der Forschungsfrage. Im nächsten Schritt wird diskutiert, mit welchen konkreten Vorgehensweisen die Generalisierung vorgenommen werden kann. [15]

5. Verfahren der Generalisierung

Es lassen sich sehr unterschiedliche Möglichkeiten differenzieren, wie eine Generalisierung von Forschungsergebnissen vonstatten gehen kann. Ich möchte hier elf verschiedene Prozeduren beschreiben:

In manchen Fällen ist die Untersuchung der gesamten Population möglich und sinnvoll. Eine Studie über Nobelpreisträger, über Weltmeister oder über Europäische Länder kann alle relevanten Fälle erheben und hat somit kein Problem der Generalisierung.

Die Falsifizierung von universellen, raum-zeitlich unabhängigen Gesetzen wurde bereits angesprochen. Sie wird vom Kritischen Rationalismus (POPPER) als einzig mögliche Prozedur der Erkenntnissicherung herausgestellt. Zur Generalisierung trägt sie nur indirekt bei, da gehofft wird, dass durch das Aufdecken falscher Generalisierungen die richtigen übrig bleiben werden.

Das Arbeiten mit Zufallsstichproben ist der übliche Weg in quantitativen Studien. Man hofft hier, dass die zufällig ausgewählte Stichprobe alle relevanten Eigenschaften der Population in gleicher Verteilung enthält. Die Größe solcher Zufallsstichproben sollte ausreichend sein (mehr als 30 Personen, vgl. Zentrales Grenzwerttheorem, BORTZ 2005) und kann genauer geschätzt werden, wenn Alphafehler, Power und Effektstärke für die statistischen Analysen festgelegt werden (vgl. COHEN 1988). In qualitativen Studien ist es zwar unüblich, aber auch möglich, mit Zufallsstichproben zu arbeiten (z.B. in einer Interviewstudie).

Oftmals sind Zufallsstichproben schwer zu erreichen (eine Liste der gesamten Population, aus der dann die Stichprobe zufällig gezogen wird, ist dafür notwendig). Hier können Stratifizierungsstrategien angewendet werden (oft auch in Kombination mit Zufallsstrategien): Bestimmte Dimensionen (z.B. Alter, Geschlecht) werden aufgrund theoretischer Erwägungen als zentral angesehen und die Verteilung dieser Variablen und der Stichprobe vorher festgelegt (n Frauen und m Männer sollen in der Stichprobe sein). Diese Merkmale können anzahlmäßig gleich groß festgelegt werden oder nach ihrer Verteilung in der Population (vgl. THOMPSON 1992).

Das Arbeiten mit größeren Stichproben kann generell als Strategie verfolgt werden. Je mehr Fälle analysiert werden, desto besser kann generalisiert werden, ist hier das Argument. Die Beschränkung auf kleine Stichproben in qualitativer Forschung folgt ja oft praktischen Erwägungen (intensive und komplexe Datensammlung nötig), eine Ausweitung des Samples (einer angemessenen Stichprobenstrategie folgend) kann also sehr hilfreich für Verallgemeinerungen sein.

Argumentative Verallgemeinerung stellt eine Ex-post-Strategie dar. Hier werden die Eigenschaften der Stichprobe im Nachhinein analysiert und es wird abgewogen, was darin verallgemeinerbar sein könnte (TERHART 1981). TERHART schlägt in diesem Zusammenhang eine spezifische Form der Generalisierung vor: Es soll bestimmt werden, welche Aspekte der Forschungsergebnisse auf welche zukünftigen Situationen und Bereiche verallgemeinerbar sind. METCALFE (2005) führt einen "Argument View"-Standpunkt an, der Generalisierung als abwägende, begründete Debatte unter Verwendung von Heuristiken versteht.

Theoretical Sampling stellt eine wichtige Generalisierungsstrategie in qualitativ orientierter Forschung dar und wurde im Rahmen der Grounded Theory (GLASER & STRAUSS 1967; STRAUSS 1987) entwickelt. Bei dieser Form der argumentativen Verallgemeinerung im Prozess der Datenerhebung ist der Grundgedanke, dass vom Beginn der Datensammlung an das Material durch Kodierungen und Verfassen von Memos im Sinne induktiver Theoriebildung analysiert wird. Die ersten Ergebnisse führen zu Überlegungen, welches weitere Material (neue Interviews, Feldbeobachtungen, Dokumente …) wichtig wären, um die Ergebnisse weiter zu bestätigen, aber auch kritisch zu hinterfragen. Dieser schrittweise Prozess soll dann zu einem Ende kommen, wenn "genügend" Evidenz für die verallgemeinerten Aussagen zusammengekommen ist (Prinzip der Sättigung).

Die Suche nach typischem Material ist eine weitere Strategie der Generalisierung. Aufgrund theoretischer Vorüberlegungen und/oder Analysen der Kontextmerkmale der untersuchten Fälle werden solche Fälle oder Erscheinungsformen von Fällen bestimmt, die typisch und damit generalisierbar für eine größere Menge von Fällen oder eine Population sind (vgl. MAYRING 2003, Kap. 4.3.17).

Variation des Phänomens, Untersuchung des Phänomens in unterschiedlichen Erscheinungsformen oder Kontexten ist eine zentrale Strategie phänomenologisch orientierter sozialwissenschaftlicher Forschung (vgl. MOUSTAKAS 1994). Die Strategie ähnelt der Suche nach Kontrastfällen, wie sie z.B. innerhalb der Grounded Theory empfohlen wird. Das Finden von Gemeinsamkeiten in den Variationen führt zu Generalisierungen.

Triangulation (vgl. DENZIN 1970) meint die Kombination oder Integration z.B. verschiedener Studien, um zu sichereren und verallgemeinerbareren Ergebnissen zu kommen. Der neue Trend in sozialwissenschaftlicher Methodologie zu "Mixed Methodology" und multimethodischen Ansätzen (TASHAKKORIE & TEDDLIE 1998; MAYRING 2001) geht in diese Richtung.

Eine letzte Strategie zur Generalisierung stellt die vergleichende Forschungsliteraturanalyse dar. Man sucht nach ähnlichen Studien und vergleicht die Ergebnisse mit den eigenen. Dies kann auch zu komplexeren Meta-Analysen führen (vgl. zu den verschiedenen Ansätzen SCHULZ 2004). [16]

Man sieht, dass es ein breites Spektrum von unterschiedlichen Möglichkeiten gibt, in quantitativen und qualitativen Studien die Forschungsergebnisse zu generalisieren. Die passende Strategie hängt wiederum von inhaltlich-theoretischen und wissenschaftstheoretischen Erwägungen ab. Sie müssen also sinnvoll auf den spezifischen Forschungskontext bezogen sein. METCALFE (2005) diskutiert hier auch die Möglichkeit, dass mehrere Generalisierungsstrategien gleichzeitig verfolgt werden können, auch wenn sie aus völlig unterschiedlichen wissenschaftstheoretischen Positionen heraus argumentieren. Er bezeichnet dies als "Ironist View". Demgegenüber würde ich argumentieren, dass eine solche "Mixed Methodology" höchstens in einem dialektischen Verhältnis, also nach neuer Synthese strebend, konzipierbar ist (vgl. MAYRING, 2007). [17]

6. Möglichkeiten der Generalisierung von Einzelfallstudien

Die Möglichkeiten der Generalisierung möchte ich nun für einen Studientyp demonstrieren, der in qualitativ orientierter Forschung häufig zur Anwendung kommt: der Einzelfallstudie. Hier ist die Notwendigkeit einer Verallgemeinerung besonders evident, da ja in aller Regel nicht der einzelne Fall an sich von Interesse ist, sondern die Schlussfolgerungen und Transfers, die wir aus dem Material ziehen können. [18]

Die erste tentative und schwächste Form der Generalisierung besteht darin, den Kontext des Einzelfalles zu analysieren und die Ergebnisse auf ähnliche Kontexte zu verallgemeinern. Wurde ein biographisches Interview mit einer jungen, männlichen Person in einer Großstadt durchgeführt, so könnten die Ergebnisse auf männliche Stadtbevölkerung im frühen Erwachsenenalter verallgemeinert werden. Dabei wäre es sinnvoll, die Generalisierungsmöglichkeiten bereits im Vorhinein zu erwägen, das heißt, die Einzelfälle nach solchen theoretischen Vorüberlegungen auszuwählen. Die Suche nach typischen Fällen, repräsentativen Fällen, häufig auftauchenden oder theoretisch interessanten Fällen stellen hier gute Strategien dar. Das heißt, es wäre sinnvoll, eine allgemeine Falldefinition (Was wäre ein guter Fall für meine Studie?) zu entwickeln und danach die Fälle auszuwählen (vgl. MAYRING 2003). [19]

Der nächste Schritt, die Resultate aus Fallanalysen zu bestätigen und zu generelleren Schlussfolgerungen zu kommen, besteht darin, die Fallbasis schrittweise zu erweitern. Die Empfehlungen in der Fallstudienliteratur gehen dahin, drei bis zehn Fälle einer Einzelfallstudie zugrunde zu legen (vgl. z.B. YIN 2005). Das Arbeiten mit Kontrastfällen, mit Theoretical Sampling, wurde bereits beschrieben. [20]

Eine letzte Möglichkeit, zu allgemeineren Schlussfolgerungen aus Einzelfallstudien zu gelangen, liegt in der längsschnittlichen Struktur des Materials. Man kann in Einzelfällen Zeitreihen identifizieren und Trends erkennen (vgl. zu den statistischen Möglichkeiten SHUMWAY & STOFFER 2006). Selbst experimentelle Designs können in Einzelfällen rekonstruiert werden: Verschiedene Interventionen (Ereignisse, Einflüsse) im Lebenslauf, Beobachtungen vor und nach solchen Interventionen, Vergleiche mit biographischen Abschnitten ohne Interventionen können zu systematischem Wissen über Interventionseffekte und deren kausaler Interpretation im Sinne experimenteller Designs führen (vgl. JULIUS, SCHLOSSER & GOETZE 2000). [21]

7. Schlussbemerkungen und Fragen

Es stellen sich also drei grundsätzliche Fragen zur Generalisierung in qualitativ orientierten Forschungsprojekten:

Ist eine Generalisierung der Forschungsergebnisse überhaupt notwendig oder wichtig?

Was ist jeweils Ziel der Generalisierung? Welche Art von Verallgemeinerungen sollen gezogen werden?

Was sind mögliche Vorgehensweisen, um zu Generalisierungen zugelangen? [22]

Der Beitrag hat versucht, die Bedeutung von Generalisierung zu unterstreichen. Generalisierung hängt dabei davon ab, zu welchen Aussagen die Studie gelangen will. In der Regel zielt man in qualitativen Studien auf Aussagen ab, die einen höheren Allgemeinheitsgrad besitzen als die gefundenen Ergebnisse. Es wurde ein weites Feld von Möglichkeiten für solche Generalisierungen aufgezeigt, gerade für qualitative Studien. Speziell Einzelfallanalysen können kaum für sich selbst stehen, sie brauchen in der Regel Verallgemeinerung. Eine reflektierte, theoriegeleitete Fallauswahl sowie eine schrittweise Verbreiterung der Fallbasis stellen dabei zentrale Strategien dar. [23]

Bortz, Jürgen (2005). Statistik für Sozialwissenschaftler (6. Auflage). Berlin: Springer.

Cohen, Jacob (1988). Statistical power analysis for the behavioral sciences (2. Auflage). Hillsdale: Erlbaum.

Denzin, Norman K. (1970). The research act: A theoretical introduction to sociological methods. Chicago: Aldine

Denzin, Norman K. (1983). Interpretive interactionism. In Gareth Morgan (Hrsg.), Beyond method: Strategies for social research (S.129-146). Beverly Hills: Sage.

Denzin, Norman K. & Lincoln, Yvonna S. (Hrsg.) (2003). The landscape of qualitative research. Theories and issues. Thousand Oaks: Sage.

Diriwächter, Rainer, Valsiner, Jaan & Sauck, Christine (2004). Microgenesis in making sense of oneself: Constructive recycling of personality inventory items. Forum Qualitative Sozialforschung / Forum: Qualitative Social Research, 6(1), Art. 11, http://www.qualitative-research.net/fqs-texte/1-05/05-1-11-e.htm [Zugriff: 10. Januar 2006].

Fahrenberg, Jochen (2003). Interpretationsmethodik in Psychologie und Sozialwissenschaften – neues Feld oder vergessene Traditionen? Forum Qualitative Sozialforschung / Forum: Qualitative Social Research, 4(2), Art. 45, http://www.qualitative-research.net/fqs-texte/2-03/2-03fahrenberg-d.htm [Zugriff: 10. Januar 2006].

Flick, Uwe (2005). Design and process in qualitative research. In Uwe Flick, Ernst von Kardorff & Ines Steinke (Hrsg.), A companion to qualitative research (S.146-152). London: Sage.

Glaser, Barney G. & Strauss, Anselm L. (1967). The discovery of grounded theory. Strategies for qualitative research. Chicago: Aldine.

Julius, Henri; Schlosser, Ralf W. & Goetze, Herbert (2000). Kontrollierte Einzelfallstudien: eine Alternative für sonderpädagogische und klinische Forschung. Goettingen: Hogrefe.

Lincoln, Yvonne & Guba, Egon (1985). Naturalistic inquiry. Beverly Hills: Sage.

Mayring, Philipp (2001). Kombination und Integration qualitativer und quantitativer Analyse. Forum Qualitative Sozialforschung / Forum: Qualitative Social Research, 2(1), Art. 20, http://www.qualitative-research.net/fqs-texte/1-01/1-01mayring-d.htm [Zugriff: 10. Januar 2006].

Mayring, Philipp (2003). Einführung in die qualitative Sozialforschung (5. Auflage). Weinheim: Beltz-UTB.

Mayring, Philipp (2007). Mixing qualitative and quantitative methods. In Philipp Mayring, Günther L. Huber, Leo Gürtler & Mechthild Kiegelmann (Hrsg.), Mixed methodology in psychological research (S.27- 36). Rotterdam: Sense Publishers.

Merton, Robert King (1968). Social theory and social structure. New York: The Free Press.

Metcalfe, Mike (2005). Generalisation: Learning across epistemologies. Forum Qualitative Sozialforschung / Forum: Qualitative Social Research, 6(1), Art. 11, http://www.qualitative-research.net/fqs-texte/1-05/05-1-17-e.htm [Zugriff: 10. Januar 2006].

Moustakas, Clark (1994). Phenomenological research methods. Thousand Oaks: Sage.

Popper, Karl R. (1935). Logik der Forschung: Zur Erkenntnistheorie der modernen Naturwissenschaft. Wien: Springer.

Sarafino, Edward P. (2005). Research methods. Using processes and procedures of science to understand behaviour. Upper Saddle River: Pearson/Prentice Hall.

Schulz, Ralf (2004). Meta-analysis: A comparison of approaches. Cambridge: Hogrefe & Huber.

Shumway, Robert H. & Stoffer, David S. (2006). Time series analysis and its applications (2. Auflage). Berlin: Springer.

Strauss, Anselm L. (1987). Qualitative analysis for social scientists. Cambridge: University Press.

Tashakkori, Abbas & Teddlie, Charles (1998). Mixed methodology: Combining qualitative and quantitative approaches. Thousand Oaks: Sage

Terhart, Ewald (1981). Intuition – Interpretation – Argumentation. Zeitschrift für Pädagogik, 25, 291-306.

Thompson, Steven K. (1992). Sampling. New York: Wiley.

Williams, Malcolm (2002). Generalization in interpretive research. In Tim May (Hrsg.), Qualitative research in action (S.125-143). London: Sage.

Winch, Peter (1958). The idea of social science. London: Routledge & Kegan.

Yin, Robert K. (2005). Case study research: design and methods (3. Auflage). Thousand Oaks: Sage.

Philipp MAYRING ist Professor für Psychologie an der Alpen-Adria Universität Klagenfurt. Er leitet die Abteilung für Angewandte Psychologie und Methodenforschung des Instituts für Psychologie sowie das Zentrum für Evaluation und Forschungsberatung (ZEF) an der Universität Klagenfurt. Seine hauptsächlichen Forschungsgebiete sind Qualitative Inhaltsanalyse, Mixed Methodology, Evaluation und angewandte Themen im Bereich Gesundheitsforschung, Wohlbefinden und lebenslanges Lernen.

Kontakt:

Prof. Dr. Philipp Mayring

Abteilung für Angewandte Psychologie und Methodenforschung

Institut für Psychologie der Alpen-Adria Universität Klagenfurt

Universitätstr. 65-67

A-9020 Klagenfurt

Tel.: 0043 463 2700 1671

Fax: 0043 463 2700 1697

E-Mail: philipp.mayring@uni-klu.ac.at

URL: http://wwwu.uni-klu.ac.at/pmayring/index.php

Mayring, Philipp (2007). Generalisierung in qualitativer Forschung [23 Absätze]. Forum Qualitative Sozialforschung / Forum: Qualitative Social Research, 8(3), Art. 26, http://nbn-resolving.de/urn:nbn:de:0114-fqs0703262.