Volume 21, No. 1, Art. 22 – Januar 2020

Qualitative Inhaltsanalysen und Grounded-Theory-Methodologien im Vergleich: Varianten und Profile der "Instruktionalität" qualitativer Auswertungsverfahren

Katja Kühlmeyer, Petra Muckel & Franz Breuer

Zusammenfassung: In diesem Beitrag vergleichen wir Varianten der qualitativen Inhaltsanalyse (QIA) und der Grounded-Theory-Methodologie (GTM) im Hinblick auf ein Charakteristikum, das wir als Instruktionalität der jeweiligen Verfahrensbeschreibungen bezeichnen. Wir verstehen dabei Instruktionalität als ein Konzept, das sich durch die dimensionalen Eigenschaften Präzision und Präskriptivität charakterisieren lässt. Beide Dimensionen können bei qualitativen Verfahren jeweils hoch/stark oder niedrig/schwach ausgeprägt sein. Im Vergleich erweist sich die QIA überwiegend als ein präziseres und stärker präskriptives Verfahren als die GTM. Neuere Lehrbücher bzw. deren Autor_innen vertreten Varianten einer QIA, die – verglichen mit früheren Darstellungen – weniger präskriptiv sind, vor allem im Hinblick auf Variationsmöglichkeiten in der Ausgestaltung der einzelnen Handlungsschritte. Gründe für die verschiedenen Instruktionalitätsprofile der qualitativen Verfahren sehen wir in ihren unterschiedlichen Entstehungsbedingungen, in unterschiedlichen Ansätzen bei der Ausbildung von Noviz_innen in qualitativer Forschung und in unterschiedlichen Herangehensweisen bei der Frage der intersubjektiven Nachvollziehbarkeit und Konsistenz der Ergebnisse. Da sich QIA und GTM hinsichtlich ihrer Instruktionalitätsprofile unterscheiden, sollte bei der Beschreibung von Hybridmethoden mit Bausteinen aus beiden Forschungsansätzen die Instruktionalität des daraus resultierenden Verfahrens reflektiert werden.

Keywords: Methodenvergleich; qualitative Inhaltsanalyse; Grounded-Theory-Methodologie; Auswertung; Codieren; Kategorien; Instruktionalität; Hybridmethoden; Qualität; Gütekriterien

Inhaltsverzeichnis

1. Einleitung: Auswertungsarbeit nach QIA und GTM

2. Instruktionalität qualitativer Forschungsmethoden

3. Vergleich der Instruktionalitätsprofile von QIA und GTM

3.1 Funktion der Forschungsfrage

3.2 Funktion des Codierens bzw. des Kategorisierens

4. Instruktionalität auktorialer Varianten der QIA und GTM

5. Gründe für Instruktionalitätsunterschiede zwischen QIA und GTM

5.1 Entstehungsbedingungen der Verfahren

5.2 Forschungsanleitungen für Noviz_innen und für erfahrene Forschende

5.3 Nachvollziehbarkeit der Ergebnisse

6. Verbindung von QIA und GTM

7. Schlussfolgerungen

Zu den Autorinnen und zum Autor

1. Einleitung: Auswertungsarbeit nach QIA und GTM

Qualitative Inhaltsanalyse (QIA) und Grounded-Theory-Methodologie (GTM)1) sind anerkannte Methodiken im Feld der qualitativen Forschung.2) Eine Vielzahl von Autor_innen hat über die Jahre ein breites Spektrum an Varianten hervorgebracht, die sich sowohl im deutschsprachigen als auch im englischsprachigen Raum etabliert haben. Auch wenn die GTM eher als eine umfassende Forschungsmethodologie sowie als eine bestimmte Denkweise – also als ein Forschungsstil – und weniger allein als Auswertungsmethode verstanden wird, ist einer ihrer wichtigsten Bestandteile ein Inventar von Verfahren zur Analyse qualitativen Datenmaterials. Sowohl GTM als auch QIA können prinzipiell zur Analyse verschiedener Datensorten benutzt werden (CHO & LEE 2014; KUCKARTZ 2016; MAYRING 2015; SCHREIER 2012). Die QIA wird zumeist für die Analyse von Texten verwendet (HSIEH & SHANNON 2005); ihre Anwendung auf andere Datensorten ist prinzipiell möglich. In der GTM ist es gemäß dem "All is data"-Prinzip (GLASER 2001, S.145) ohne Weiteres möglich, neben Texten auch andere Materialien, beispielsweise materielle Objekte, Beobachtungs- und visuelle Daten, einzubeziehen (GLASER & STRAUSS 1967; MEY & DIETRICH 2016; STRAUSS & CORBIN 1998 [1996]). [1]

Die unterschiedlichen Varianten von Verfahrensweisen, die in der Tradition von QIA und GTM entwickelt wurden, stehen in direkter Verbindung mit den Autor_innen der Lehrbücher und Fachartikel, in denen sie beschrieben wurden. Sie weisen Gemeinsamkeiten und Unterschiede auf, die in der Methoden-Diskussion immer wieder aufs Neue re-/konstruiert werden. Mit beiden Verfahren erarbeiten Forschende auf systematische Weise verallgemeinernde Konzepte bzw. Begriffe, sogenannte Kategorien, die mit dem Datenmaterial auf bestimmte Art und Weise in Verbindung stehen. Dabei sind die Vorgehensweise bei der Kategorienbildung und die Funktion der erarbeiteten Kategorien nach GTM und QIA unterschiedlich (CHO & LEE 2014; JANSSEN, STAMANN, KRUG & NEGELE 2017; MUCKEL 2011; WOLLNY & MARX 2009). [2]

In Gegenüberstellungen zwischen QIA und GTM, die sich u.a. auf die disziplinären Herkunftstraditionen, die methodologische Reichweite, die Angemessenheit und Zielsetzung, die jeweils charakteristischen Ergebnisse sowie auf Gütekriterien beziehen, lassen sich weitere Gemeinsamkeiten und Unterschiede der beiden Verfahren finden (CHO & LEE 2014; MUCKEL 2011; WOLLNY & MARX 2009). In den uns bekannten Artikeln, die sich mit dem Vergleich der Verfahren (oder von Aspekten daraus) beschäftigen, werden QIA und GTM in der Regel vereinfacht dargestellt, indem die Variantenvielfalt ausgeblendet und die Beschreibung auf ein Werk, eine_n Autor_in eines Werks, eine Durchführungsform oder einen Teilschritt des Verfahrens reduziert wird (GLÄSER & LAUDEL 2013; WOLLNY & MARX 2009). [3]

In diesem Artikel widmen wir uns einem Vergleich der QIA und der GTM hinsichtlich ihrer Beschreibungen in einigen Methodenbüchern durch exemplarisch ausgewählte Vertreter_innen. Wir beschäftigen uns anhand dieser Beispiele mit dem Stellenwert der beschriebenen Vorgaben für die forschungspraktische Anwendung von Verfahren. Für die QIA beziehen wir uns vorwiegend auf KUCKARTZ (2016), MAYRING (2015) und SCHREIER (2012), darüber hinaus verweisen wir stellenweise zu Zwecken der Abgrenzung auf die "klassische" Inhaltsanalyse (FRÜH 2004, 2015). Hinsichtlich der GTM beziehen wir uns vorwiegend auf die zunächst englischsprachigen Werke, vor allem auf GLASER (1978, 1992), STRAUSS (1991a [1987]), STRAUSS und CORBIN (1998 [1996]) sowie auf CHARMAZ (2006, 2014). Dabei zielen wir anhand dieser beispielhaften Methodenbeschreibungen auf eine Betrachtung ab, in welcher der Prozess des Zur-Anwendung-Bringens von Verfahren eine Rolle spielt, und bei der das Verhältnis von Methode und Forscher_in im Forschungsprozess in den Blick kommt. Die Explikation des In-Beziehung-Setzens zwischen Forscher_in und Methode kann wiederum Personen mit wenig Forschungserfahrung bei der Entscheidung zwischen den beiden Verfahren eine Hilfsstellung sein. [4]

Wir möchten in diesem Beitrag ein Charakteristikum der Verfahren bzw. ihrer Beschreibungen stärker sichtbar machen, das bisher wenig Aufmerksamkeit erhalten hat, aber in einem Spannungsverhältnis mit der forschenden Person und ihrer Haltung steht – nicht zuletzt auch mit der Bereitschaft, sich und das eigene Denken durch die Auseinandersetzung mit einer qualitativen Forschungsmethode verändern zu lassen (BREUER, MUCKEL & DIERIS 2019). Ausgangspunkt unserer Überlegungen waren unsere eigenen Erfahrungen mit der Deutungsarbeit nach QIA und GTM, vor allem in Bezug auf das Codieren (nach GTM) bzw. die Kategorienbildung am Material (nach QIA). Das zentrale Charakteristikum der Anleitung zur Auswertung mit QIA und GTM, das wir im Folgenden thematisieren, ist das der Instruktionalität einer Methode. [5]

Zunächst stellen wir unser Verständnis von Instruktionalität vor (Abschnitt 2). Im darauf folgenden Abschnitt 3 vergleichen wir die Instruktionalitätsprofile von GTM und QIA, u.a. auch im Hinblick auf Unterschiede zwischen verschiedenen Varianten bzw. zwischen den durch unterschiedliche Autor_innen beschriebenen Verfahrensweisen (Abschnitt 4). Wir konzentrieren uns dabei auf die Funktionen von Forschungsfrage und Kategorisierungspraxis. Im Anschluss zeigen wir einige Gründe für die erläuterten Unterschiede auf (Abschnitt 5). Sodann geben wir einen Ausblick auf mögliche programmatische Verbindungen von Bestandteilen der QIA und der GTM – wir nennen diese Verbindung "Hybridmethoden" – und skizzieren Aspekte, die vor dem Hintergrund ihrer unterschiedlichen Instruktionalität bei der Kombination dieser Verfahren zu beachten sind (Abschnitt 6). Zuletzt formulieren wir einige Schlussfolgerungen (Abschnitt 7). [6]

2. Instruktionalität qualitativer Forschungsmethoden

Eine wesentliche Aufgabe Forschender bei der Anwendung qualitativer Methoden ist die regelgeleitete Transformation von (häufig textförmigen) Daten in eine abstrakt-konzeptuelle Form. Die Verwendung erprobter und beschriebener "Transformationsmethoden" erleichtert Forschenden dabei die Plan-, Wiederhol- und Darstellbarkeit einer Forschung. [7]

Qualitative Verfahren, verstanden als schriftlich fixierte Anleitungen zum Forschen, lassen sich in Bezug auf ihre Bestandteile oder ihr Selbstverständnis charakterisieren. Eines dieser Charakteristika ist der in ihnen verwirklichte Anspruch, das Vorgehen mithilfe eines Verfahrens vorab zu regeln bzw. den Forschenden den Freiraum zu lassen, es am Gegenstand oder an persönlichen bzw. professions- oder disziplinspezifischen Präferenzen auszurichten. In unseren Überlegungen geriet so das grundlegende methodologische Konzept der Regelgeleitetheit der Auswertungs- bzw. Codiermethodik für die beiden Verfahrensgruppen in die Diskussion: Wie präzise elaboriert und wie verbindlich formuliert sind die Hinweise (Vorschriften, Anregungen) für die Codier- bzw. Strukturierarbeit an Datenmaterialien (u.a. Texten) in qualitativen Verfahren? [8]

Um einen Aspekt dieses Regelungsanspruches qualitativer Verfahren näher zu bestimmen, schlagen wir den Begriff der Instruktionalität vor, mit dem wir den Anweisungs-, Regel- oder Vorschriftscharakter einer Methode bezeichnen. Die Instruktionalität einer Methode kann im Hinblick auf die sie charakterisierenden Merkmale unterschiedliche Ausprägungsgrade einnehmen. Wir können feststellen, dass sich QIA und GTM durch verschiedenartige Ausprägungen dieser Merkmale (wir nennen sie Instruktionalitätscharakteristika) auszeichnen. Wir nennen die Verteilung der Ausprägungen dieser Charakteristika in der jeweiligen Methode ihr Instruktionalitätsprofil. Nimmt man Vertreter_innen der jeweiligen Methode in den Blick (prototypisch: Methodenlehrbuchautor_innen), stellt sich heraus, dass QIA und GTM nicht einheitlich-monolithisch konzipiert und kanonisiert sind. Vielmehr lassen sich durchaus unterschiedliche Profilcharakteristika des Instruktionalitätskomplexes innerhalb von QIA und GTM feststellen. Autor_innen von Methodenlehrbüchern akzentuieren wiederum Instruktionalitätsmerkmale der Methode unterschiedlich, sie betreiben Instruktionalisierung. [9]

Wir sind der Überlegung nachgegangen, inwieweit sich die Merkmale dieses Konzepts ausdifferenzieren lassen. Wir explizieren das Konzept Instruktionalität durch zwei Dimensionen:

die Präzision oder Genauigkeit, Detailliertheit, Eindeutigkeit (vs. Ungenauigkeit, Mehrdeutigkeit, Vagheit) der Vorgabe, mit der eine Vorgehensweise beschrieben wird: Wie eindeutig, detailliert formuliert und ausgearbeitet sind die Regelwerke des Codierens durch Autor_innen in den beiden Verfahren? Wie genau spezifizieren sie die Regeln und Relevanzen des Vorgehens? In welchem Grad von Präzision wird das Verfahren ausgestaltet?

die Präskriptivität3) oder den Verpflichtungscharakter, die Verbindlichkeit (vs. Vorschlagscharakter, Unverbindlichkeit), die eine Beschreibung des methodischen Vorgehens gegenüber Gegenstand und Forscher_in beansprucht: Wie verbindlich werden die Regeln des Codierens verfasst? Werden sie als verpflichtend zu befolgende Vorschriften geltend gemacht, oder werden sie als Vorschläge und Anregungen präsentiert? Wie strikt werden einschlägige Praktiken nach "richtig" und "falsch" unterschieden?4) [10]

Die beiden Eigenschaften können bei den Verfahren unterschiedlich ausgeprägt sein – von einem Mindest- bis zu einem Höchstmaß. Auch einzelne Praktiken innerhalb eines Verfahrens können wir im Hinblick auf diese Merkmale charakterisieren. Die beiden Dimensionen sind nach unseren Überlegungen dabei als sachlogisch unabhängig voneinander modellierbar, es gibt keinen zwingenden Zusammenhang zwischen Präzision und Präskriptivität. Wir beschäftigen uns hier mit dem QIA-GTM-Vergleich, gehen aber davon aus, dass das vorgeschlagene Instruktionalisierungskonzept und die Betrachtung der Instruktionalitäts- (oder Instruktionalisierungs-)Profile auch für die Charakterisierung anderer Methoden tauglich und interessant sind. [11]

Die Kombination der beiden Dimensionen unseres Instruktionalitätskonstrukts Präzision und Präskriptivität, die in ihren Ausprägungen das Profil der Instruktionalität einer Methode ergeben, können in einer zweidimensionalen Kontingenztafel orthogonal miteinander in Beziehung gesetzt werden, wodurch sich in Tabelle 1 vier typisierbare Felder ergeben.

|

|

Hohe Präzision: Genauigkeit |

Niedrige Präzision: Vagheit |

|

Hohe Präskriptivität: Verbindlichkeit |

[Feld a] |

[Feld b] |

|

Niedrige Präskriptivität: Unverbindlichkeit |

[Feld c] |

[Feld d] |

Tabelle 1: Vierfeldertafel zur Charakterisierung des Instruktionalitätsprofils einer Methode [12]

Die Instruktionalitätsprofile beziehen sich auf die Beschreibung bzw. (auktoriale) Anleitung des methodischen Vorgehens. Sie können wie folgt als Idealtypen charakterisiert werden:

Feld a: Eine methodische Vorgehensweise wird in großer Detailliertheit und Genauigkeit beschrieben, und der Anspruch ihrer Verbindlichkeit wird hoch angesetzt. Zum einen wird bis ins Einzelne gehend vorgegeben, welche Handlungsschritte vorgesehen sind, zugleich werden diese Handlungsschritte als verbindlich für die regelgerechte Verwendung der Methode dargestellt.

Feld b: Eine Handlungsvorschrift kann relativ vage und im Ungefähren formuliert und dennoch als verpflichtende, verbindliche Handlung im Methodenrepertoire vorgeschrieben sein – beispielsweise im Sinne von: "Um einem Verfahren das Label X geben zu dürfen, müssen wenigstens diese drei Schritte vollzogen worden sein".

Feld c: Man kann eine Vorgehensweise präzise, genau und detailliert beschreiben, sie zugleich aber lediglich als Vorschlag, Möglichkeit oder Anregung formulieren.

Feld d: Wir haben es in diesem Feld mit unscharf gefassten, vielfältig auszudeutenden und zu konkretisierenden Vorgaben zu tun – Werkzeuge in der Hand der Forscher_innen, die flexibel und kreativ gehandhabt werden können; sie können so genutzt werden – oder auch nicht oder auch anders. Hier gibt es Raum für die Kreativität der Forscher_innen und die Flexibilisierung ihrer Vorgehensweisen, für eine Anpassung des Verfahrens an den Gegenstand, den Forschungskontext und das Erkenntnisinteresse. [13]

Es gibt prinzipiell eine Grenze des Präzisionsgrades von Anleitungen: Die Beschreibung ist nicht die Handlung selbst. In jedem Fall ist mit der Umsetzung der Vorschrift eine Deutungsnotwendigkeit verbunden. Dabei gibt es ein unaufhebbares Bedeutungssurplus – sowohl des Handelns gegenüber der Beschreibung (Handlungsbeschreibungen bleiben auch bei großer Detailliertheit unvollständig und durch Vagheiten gekennzeichnet, es gibt stets noch alternative Beschreibungsmöglichkeiten einer Handlung) wie auch der Beschreibung gegenüber dem Handeln (es können unterschiedliche Handlungspraktiken unter eine Beschreibung gefasst werden). Die von Autor_innen einer Handlungsvorschrift als notwendig angesehene Präzision der Formulierung einer Handlungsanweisung kann auch etwas mit ihren Adressat_innen zu tun haben – etwa bezüglich deren forschungsmethodischer Vorerfahrung und Expertise (Abschnitt 5.2).5) [14]

3. Vergleich der Instruktionalitätsprofile von QIA und GTM

Die einzelnen Elemente der jeweiligen Verfahren lassen sich in Bezug auf ihre Instruktionalitätsprofile unterschiedlich charakterisieren. Dabei betrachten wir im Folgenden die Funktion der Forschungsfrage und des Codierens bzw. der Kategorienbildung. [15]

3.1 Funktion der Forschungsfrage

Wir sehen eine Unterschiedlichkeit der Instruktionalitätsprofile von QIA und GTM im Hinblick auf die Bedeutung der Formulierung einer Forschungsfrage für die Datenanalyse. Für die QIA ist die Orientierung an einer vorgängigen Forschungsfrage obligatorisch, diesbezüglich ist deren Vorgabe hoch präskriptiv. Eine Engführung des Auswertungsvorgehens beginnt in der QIA bei der Ausgestaltung der Fragestellung, die möglichst konkret formuliert sein soll (WOLLNY & MARX 2009). Durch die Fragestellung werden die denkbaren Fokussierungen und Sichtweisen auf das Datenmaterial bereits zu Beginn der Auswertung eingegrenzt, und die Analyserichtung wird vorgegeben (SCHREIER 2012). MAYRING (2015) fordert, die Fragestellung durch die Einordnung in ein Kommunikationsmodell näher zu bestimmen und theoriegeleitet zu differenzieren, wobei er Freiheitsgrade in der Wahl und Applikation des entsprechenden Modells zu lassen scheint. Zusammenfassend betrachtet wird die Funktion einer Forschungsfrage in verschiedenen QIA-Lehrbüchern stark präskriptiv sowie im Sinne eines Postulats hoher Präzision thematisiert. [16]

Unter einer GTM-Orientierung arbeiten Forscher_innen zwar ebenfalls geleitet von einem vorgängigen allgemeinen Erkenntnisinteresse, aber das untersuchte Phänomen wird zunächst mit "offenem Blick" und in einer gewissen gegenstandsbezogenen Breite betrachtet. Es handelt sich zu Beginn um noch nicht scharf formulierte und fixierte Forschungsanliegen, die "[...] uns die notwendige Flexibilität und Freiheit geben, ein Phänomen in seiner Tiefe zu erforschen" (STRAUSS & CORBIN 1998 [1996], S.22). Mithilfe der Formulierung eines Anliegens können Forscher_innen sich den Gegenstandbereich erschließen und erste empirische Zugriffe entwickeln. Im Forschungsprozess spezifizieren sie sodann (u.a. in Zusammenhang mit dem Prinzip des Theoretical Sampling, das eine Auswahl empirischer Fälle in einer sukzessiv-iterativen Bewegung in Koordination mit Schritten der Theorie-Generierung beinhaltet) ihr frühes Forschungsanliegen zu einem Forschungsthema. Forscher_innen durchlaufen einen Fokussierungsprozess, in dem sie Kategorien und deren modellförmige Konfiguration (idealtypisch um eine Kernkategorie herum) herausarbeiten (BREUER et al. 2019). Das Operieren mit einem allgemeinen Erkenntnisinteresse ist ein weniger präzise gefasster Vorgang, der einer operierenden Person viele Freiheitsgrade lässt. Dieser Schritt stellt sich im Verfahren also hoch präskriptiv bei geringer Präzision dar. [17]

Zusammenfassend halten wir fest, dass mithilfe der Forschungsfrage in der QIA eher der Gegenstand vorab fixiert werden soll, während in der GTM damit der Forschungsprozess erst eröffnet wird. Mit dieser funktionalen Gegensätzlichkeit kann man unserer Ansicht nach die unterschiedlichen Profile der Präzision und Präskriptivität der Methodiken veranschaulichen. [18]

3.2 Funktion des Codierens bzw. des Kategorisierens

Unter dem Begriff Codieren werden in den beiden Methodiken gemeinhin unterschiedliche Dinge gefasst. Während in der GTM damit die Überführung von (meist textförmigen) Daten (Interviewtranskripten, Texten/Daten anderer Art) in eine kategoriale Form verstanden wird, bezeichnet der Begriff in der strukturierenden QIA6) die Zuordnung von Textstellen zu Kategorien als einen der Entwicklung eines Kategoriensystems und Codierleitfadens nachgeordneten Verfahrensschritt. Die Tätigkeit des Offenen Codierens nach der GTM weist Ähnlichkeiten zur induktiven (daten-inspirierten) Kategorienbildung in der QIA auf, aber es bestehen auch gravierende Unterschiede (KUCKARTZ 2016; SCHREIER 2014). [19]

In der Codierarbeit der GTM sollen bedeutungstragende Begriffe unterschiedlichen Textstellen zugeordnet werden. Die dahinterstehende Erkenntnisidee ist die Folgende: Die Buntheit und Vielfalt der phänomenalen (Text-)Welt ist durch ein abstraktiv-reduziertes und systematisiertes Netz überschaubarer zugrunde liegender Konzepte/Kategorien darstellbar. Kategorienorientierte qualitative Verfahren im Allgemeinen basieren auf dieser Idee der Deutungsarbeit: Aus dem schwer überschaubaren "Gerausche" der Datenwelt soll eine begrenzte Anzahl an Kategorien, Typen, Mustern u.Ä. herausdestilliert und theoretisch systematisiert werden. [20]

Methodenanleitungen legen verschiedenartige Prozeduren nahe, um diesen Transponierungs- und Reduktionsschritt zu vollziehen. In den GTM-Lehrbüchern wird der Vorgang des Codierens häufig als Relationierung im Rahmen eines Konzept-Indikator-Modells bezeichnet: Daten(-ausschnitte) werden als Anzeichen, Indikatoren für (dahinterliegende) Konzepte (Kategorien, Konstrukte) benutzt. Das Codieren in der GTM dient der Entwicklung einer Theorie. Endpunkt der Analyse ist die Theorie und nicht das vollständige Codieren des Materials, wie es in der QIA angestrebt wird (KUCKARTZ 2016). Die Kategorisierung in der QIA dient vorwiegend der Strukturierung des Materials als Vorarbeit zur Beantwortung der Fragestellung, wobei die Beantwortung dann mitunter Textinterpretationen (z.B. Paraphrasierungen) erfordert. [21]

Die theoretischen Hintergründe, die als Deutungsvoraussetzungen herangezogen werden sollen, können sowohl beim Codieren in der GTM als auch bei der Kategorienbildung in der QIA unterschiedlich gewählt werden. So lässt sich etwa eine Prozedur, bei der die Datentexte hinsichtlich ihrer manifesten Inhaltscharakteristik (etwa bezüglich der Verwendung bestimmter sprachlicher Ausdrücke, synonymer Worte – an der textuellen Oberfläche) betrachtet werden, von einer Version unterscheiden, in der es um (theoretisch zu fokussierende – etwa psychoanalytisch, sozial-/gesellschaftstheoretisch, zeitgeschichtlich) tiefenstrukturelle Charakteristika von beschriebenen Handlungen geht. Mitunter werden auch die sozialen und interaktiv-kommunikativen Umstände (Konstellationen, Situationen, Kontexte, Verläufe), in denen die Daten produziert worden sind, bei der Interpretation berücksichtigt. [22]

Der Codierarbeit im GTM-Modus liegt ein sub-/kulturelles Verständnis von (reflexiven) sozialisierten Alltagswelt-Angehörigen als Interpretationsfolie zugrunde – ohne das Verstehen/ Interpretieren gar nicht möglich ist. Dem steht das Postulat der theoretischen Offenheit gegenüber (GLASER 2013; GLASER & STRAUSS 1967), das sinnvollerweise nicht in einer Tabula rasa-Version verstanden werden kann, dennoch aber als Interpretationshaltung von Bedeutung ist, um kreativ-innovative Potenzen der Methodik realisieren zu können, eine Haltung, die unter anderem von Ronald HITZLER (2001) als "künstliche Dummheit" beschrieben wurde. Hier kommt eine Paradoxie des Verfahrens zum Vorschein: zwischen dem Befolgen der Maxime "No Preconceptions!" (GLASER 2013) und dem Wissen darum, dass eine absolute theoretische Offenheit sowie ein Emergieren-Lassen ohne eine Person, in deren Denkwelt das geschieht, nicht möglich ist. In den Lehrbüchern der GTM heißt die Zauberformel an dieser Stelle theoretische Sensibilität (GLASER 1978). Das (multipel konstituierte und unterfütterte) Gespür der Codierenden für gegenstandstheoretische Relevanzen und Strukturbildung ist von allergrößter Bedeutung für das Codierergebnis, und man kann sich in dieser Hinsicht mehr oder weniger un-/geschickt anstellen. Neben alltagsweltlichen Wissens- und Erfahrungshintergründen können hierbei auch aus vielfältigen (wissenschaftlichen, professionalen, subkulturellen und anderen) Denkwelten adaptierte Figuren (Fokussierungs- und Begriffsbildungsvarianten) als Konzeptualisierungsmöglichkeiten ins Spiel kommen (KELLE 2005). Der Kreativität der Codierenden sind dabei keine prinzipiellen Grenzen gesetzt. Postuliert werden muss allerdings, dass dies auf eine reflektiert-selbstreflexive Weise geschieht (BREUER et al. 2019). [23]

Es gibt in der Methodenliteratur zwar schriftlich fixierte Richtlinien, wie das Codieren vonstattengehen sollte, diese reichen jedoch für das Erlernen und die praktische Umsetzung nicht aus. Regeln für Codierprozeduren sind nur relativ vage formuliert, eher in Form von Vorschlägen, Anregungen und modellgebenden Beispielen als von obligatorisch zu befolgenden Regeln – und damit niedrig präzise und niedrig präskriptiv. Das Vorgehen wird mitunter als "hemdsärmelig" bezeichnet (HITZLER & EISEWICHT 2016, S.70). Erlernen kann man die Praxis beim Selbermachen – idealerweise im Kontext von Codiergruppen und unter Anleitung einer erfahrenen GTM-Forscherin oder eines erfahrenen GTM-Forschers. Dabei können wir davon ausgehen, dass die Praxen in unterschiedlichen (lokalen) GTM-Interpretationsgruppen zwar gewisse Ähnlichkeiten aufweisen, aber auch durch Unterschiede gekennzeichnet sind. [24]

Mit der Vorgabe von Regeln bzw. Handlungsanweisungen in der QIA fordern die Autor_innen eine ganz bestimmte Abfolge von Handlungen ein (HSIEH & SHANNON 2005; MAYRING 2015; SCHREIER 2012), was wir als präskriptive Vorgabe verstehen. In der strukturierenden QIA nach KUCKARTZ (2016), MAYRING (2015) und SCHREIER (2012) ist die Erarbeitung eines Codierleitfadens unerlässlich und steht im Zentrum der Arbeit mit Kategorien. Diese Vorgabe ist hoch präskriptiv. Bei der daten-inspirierten (induktiven) Kategorienbildung, die ebenso wie eine theorie-inspirierte (deduktive) Kategorienbildung für die Entwicklung eines Codierleitfadens herangezogen werden kann, ist die Festlegung und Einhaltung eines Abstraktionsniveaus von Kategorien notwendig (MAYRING 2015; WOLLNY & MARX 2009); es handelt sich somit um eine weitere präskriptive Vorgabe. In der Auswertung anhand eines Codierleitfadens separieren Forscher_innen dann Bestandteile des Textes voneinander und grenzen ein, welche Teile des Materials in der Auswertung wie berücksichtigt, also welche Kategorien in den Codierleitfaden aufgenommen werden. Es werden nur die Bestandteile des Datenmaterials ausgewählt, die für die Beantwortung der Forschungsfrage relevant erscheinen. Durch die Arbeit am Codierleitfaden werden Kategorien zu einem frühen Zeitpunkt im Forschungsprozess definiert und fixiert. Für jede Kategorie werden "Ankerbeispiele" formuliert, mitunter mit dem Ziel, dass das Datenmaterial, das anhand von bereits codierten Beispielen zuvor als relevant eingestuft worden ist, ausschließlich und eindeutig (trennscharf) einer Kategorie zugeordnet werden kann (SCHREIER 2012). Bei der zusammenfassenden QIA bzw. dem Vorgehen bei der am Material entwickelten Kategorienbildung legt MAYRING (2015) vorrangig Wert auf die methodische Absicherung der Eindeutigkeit in den Zuordnungsprozessen zwischen entwickelten Kategorien und Textstellen (WOLLNY & MARX 2009). [25]

In der GTM werden Kategorien in einer iterativen Such- und Abstraktionsbewegung zwischen Erhebung/Sampling und Analyse auf der Grundlage der Daten entwickelt, sie bleiben über eine längere Zeit des Forschungsprozesses fluide Elemente (STRAUSS & CORBIN 1998 [1996], S.279). Die fluiden bzw. hypothetischen Kategorien aus dem GTM-Prozess können im Laufe der Zeit sowohl verändert und reformuliert als auch in ihrer Bedeutung für die datenbegründete Theorie unterschiedlich ein-/geordnet und gewichtet werden. Über weite Strecken des Forschungsprozesses bleibt offen, welchen Stellenwert eine Kategorie im finalen Theorieentwurf bekommt, ob sie eventuell zu einer Kernkategorie wird, oder ob sie aufgrund ihrer Irrelevanz unter der gewählten thematischen Fokussierung nicht berücksichtigt wird. Kategorien sind in der GTM-Denkwelt die tragenden Elemente der entwickelten Theorie, und sie werden in ihren Verbindungen/Beziehungen zueinander modelliert (bei STRAUSS [1991a (1987)] und STRAUSS & CORBIN [1998 (1996)] heißt das axiales und selektives Codieren, bei GLASER [1978] theoretisches Codieren und CHARMAZ [2006, 2014] spricht von initialem und fokussiertem Codieren). [26]

Es kann bei der QIA durchaus zu Revisionen eines Kategoriensystems kommen, wenn eine Kategorie zu einem späteren Zeitpunkt aufgenommen, entfernt oder reformuliert werden muss. Diese kleinen Iterationen – im Sinne eines Zurückgehens hinter einen bereits absolvierten Handlungsschritt, um diesen erneut zu absolvieren – werden bis einschließlich der sogenannten Pilotphase (SCHREIER 2012, S.146ff.) in der Entwicklung eines Codierleitfadens vorgenommen. Danach werden weitere Iterationen vermieden, weil sie mit Mehraufwand verbunden sind, denn das gesamte Material muss nach einer Änderung während der Hauptanalysephase erneut codiert werden (SCHREIER 2012; WOLLNY & MARX 2009). [27]

In der QIA wird die Arbeit der Forscher_innen also nicht nur durch die vorgängig festgelegte Fragestellung geleitet, sondern auch durch fixierte Kategorisierungsregeln und das Kategorisieren als Praxis. Die Vorgaben für die Bearbeitung von Text werden sowohl hoch präzise als auch hoch präskriptiv gestaltet. Werden dann wiederum Regeln für Zweitcodierer_innen erstellt, lenken Erstcodierer_innen mit diesen Regeln deren Arbeit und Blick auf das Material in ähnlicher Art und Weise. Durch die Ausgestaltung der Methodik wird also die Erstellung und Anwendung von Handlungsanweisungen nach vorgegebenen Regeln nahe gelegt. Meist ist ein zentrales Ergebnis einer QIA ein Kategoriensystem, häufig, aber nicht grundsätzlich in Form einer hierarchisch organisierten Liste von Kategorien (STAMANN, JANSSEN & SCHREIER 2016), die Forscher_innen in einer geeigneten Art und Weise verarbeiten und präsentieren müssen, z.B. als Tabelle oder als Text mit Zitaten (SCHREIER 2012). Auch eine Berechnung von Häufigkeiten der vorgefundenen Kategorien (u.U. gefolgt von einer statistischen Auswertung) kann sich anschließen. Codieren im Rahmen einer QIA mehrere Forscher_innen das gleiche Material, bemühen sie sich um die Herstellung von Konvergenz – um ein gemeinsames Verständnis hinsichtlich der Kategorien (HOPF & SCHMIDT 1993). Messtheoretisch lässt sich diese Idee der intersubjektiven Verständnis-/Urteils-Übereinstimmung, der Konvergenz, als Reliabilität fassen. In diesem Rahmen werden u.U. auch statistische Verfahren angewandt, um solche Übereinstimmungswerte zu berechnen (Abschnitt 5.3). [28]

In der Denkwelt der GTM wird dem gegenüber dem Charakteristikum der Divergenz, des Kontrasts zwischen den Sichtweisen von Interpretierenden/Codierenden große Wertschätzung entgegengebracht. Während ein Anspruch des Gleich-Verstehens in der QIA-Methodik gleichsinnig-konsensuelle Interpretationen begünstigt, erfordert das Nachspüren gegenüber Interpretationsdifferenzen und -divergenzen im Forschungsstil der GTM einen gewissen Mut der Forscher_innen und eine intensive Arbeit mit Perspektiven und Deutungsspielräumen – mit beidem wird ein kreativ-entdeckender Charakter der Datenanalyse betont (BREUER et al. 2019). Eine herausgehobene Bedeutung in der Methodologie der GTM hat die Heuristik des Vergleichens, des Kontrastierens, als ein zentrales Prinzip der Theorienentwicklung, der Entdeckung des Neuen. Dieser Aspekt steht in unserer dimensionalen Sortierung der Instruktionalität für höhere Präskriptivitäts- und geringere Präzisionswerte. [29]

In den Beschreibungen des Vorgehens bei MAYRING (2015) oder bei HSIEH und SHANNON (2005) bleibt es vage oder ganz ausgespart, wie ein Codierleitfaden in das (Be-)Schreiben von Ergebnissen übersetzt wird. Der Entstehungs- und Entwicklungsprozess einer Theorie in der GTM wird im Vergleich dazu durch das Schreiben von Memos begleitet und geleitet. Aufzeichnungen, in denen Erkenntnisschritte beschrieben und reflektiert werden, werden darin fixiert und gepflegt (BREUER et al. 2019; WOLLNY & MARX 2009). Forscher_innen schreiben Memos und benutzen ein Forschungstagebuch als Medien der Reflexion. Durch das Verfassen prozessbegleitender Memos üben Forscher_innen einerseits das Schreiben (ein), andererseits wird die gedankliche Entwicklung ihrer datenbegründeten Theorie gefördert. Memos sollen immer wieder gelesen, verdichtet, geordnet und fortgeschrieben werden. Jede_r Forscher_in entwickelt dabei einen persönlichen Stil. Das Memoschreiben ist eine hoch präskriptive Vorgabe, wird aber wenig präzise beschrieben. Zusammenfassend erfordern die Kategorienbildung in der QIA bzw. das Codieren in der GTM nicht nur unterschiedliche Tätigkeiten, die Verfahrensweisen unterscheiden sich auch im Hinblick auf ihre Instruktionalitätsprofile. [30]

4. Instruktionalität auktorialer Varianten der QIA und GTM

Wir schreiben der QIA – über alle Varianten (bzw. Anleitungen durch Vertreter_innen) hinweg betrachtet – hinsichtlich ihrer Instruktionalitätsprofile sowohl im Hinblick auf die Präzision der Beschreibung des methodischen Vorgehens wie auch bezüglich der Präskriptivität der Vorgehensvorschriften hoch ausgeprägte Werte zu (Feld a). Die strukturierende QIA nach KUCKARTZ (2016) und SCHREIER (2012, 2014) sowie die Technik der Strukturierung nach MAYRING (2015) lassen allerdings auch Freiräume in der Auswahl von Varianten zu, wobei diese gleichzeitig ausführlich und genau beschrieben sind, beispielsweise die evaluative oder typisierende Inhaltsanalyse (KUCKARTZ 2016). Das Codieren gemäß der klassischen Inhaltsanalyse (FRÜH 2015; KUCKARTZ 2016) würden wir demgegenüber als noch höher präskriptiv/präzise beschriebenes Vorgehen bezeichnen. Nach ihr arbeiten Forschende vorwiegend mit Kategorien, die in theoretischen Vorüberlegungen gebildet werden und subsumieren das Material sukzessive unter diese Kategorien. Die ausführlich/genau beschriebene und zugleich verbindliche Vorgehensweise ermöglicht eine quantitativ orientierte Auswertung von Texten, in denen die Anwender_innen eines Kategoriensystems (Codierer_in) so stark in den Hintergrund treten können, dass Computeralgorithmen die Auswertung vollautomatisch anhand eines so genannten "Diktionärs" ausführen können. [31]

Über die Jahre der Methodenentwicklung hat die Präzision (im Sinne von Detailliertheit) in den Beschreibungen des Vorgehens in Methodenlehrbüchern zur QIA zugenommen. Damit einhergehend scheint sich die Verbindlichkeit einer bestimmten Vorgehensweise innerhalb der QIA variantenreicher darzustellen. Inzwischen werden auch weniger präskriptive Anleitungen mit eingeschlossen. Im Gegensatz zu einem relativ eng ausgestalteten, für jede Technik ausbuchstabierten Ablauf, wie er sich bei MAYRING (2015) finden lässt, vertritt beispielsweise SCHREIER (2014, §58) einen "Werkzeugkastenmodell" der QIA: Forscher_innen stellen die für den jeweiligen Forschungsprozess geeigneten Tools zusammen und können sich dabei auch bei anderen Leitfäden zur Technik des Codierens (SALDAÑA 2016) bedienen. KUCKARTZ findet den Werkzeugkasten von SCHREIER attraktiv, denn

"[...] er öffnet den Blick für methodische Alternativen und verhindert das Denken in fixierten Schablonen [...]. Ein solches Tableau von Orientierungsalternativen demonstriert, dass es eine beeindruckende Vielfalt von Möglichkeiten in der qualitativen Inhaltsanalyse gibt und arbeitet dadurch solchen Vorurteilen methodischer Engführung entgegen" (KUCKARTZ 2016, S.225). [32]

Wo MAYRING (2015, S.50) von "Regeln" spricht, verwendet KUCKARTZ (2016, S.73) den Begriff "Guideline" und betont Freiheitsgrade in der Ausgestaltung des Vorgehens im konkreten Forschungsvorhaben. KUCKARTZ (2016) und SCHREIER (2012) operieren hinsichtlich der Präzision des beschriebenen Vorgehens genauer und ausführlicher als MAYRING (2015), z.B. im Hinblick auf die Beschreibung der Herstellung eines Codierleitfadens oder der sich an das Codieren anschließenden Analysen und Beschreibungen. Bezüglich der Präskriptivität des Verfahrens halten sie sich hingegen mehr zurück. [33]

Die Instruktionalitätsprofile der Beschreibungen unterschiedlicher GTM-Vertreter_innen sind variantenreicher. Die GTM nach STRAUSS (1991a [1987]) und STRAUSS und CORBIN (1998 [1996]) gibt auf beiden Dimensionen den Eindruck vergleichsweise niedriger Werte (Tendenz in Richtung auf Feld d). Anselm STRAUSS benennt in einem Interview (LEGEWIE & SCHERVIER-LEGEWIE 2004) drei Elemente, die gegeben sein müssen, damit der Forschungsprozess unter das Label "GTM" gestellt werden kann. Dafür müssen Theoretical Sampling, Vergleichen/Kontrastieren und Codieren realisiert werden. Diese Verfahrenskomponenten sind flexibel adaptierbar. Der Anspruch an ihr Vorhandensein ist hoch präskriptiv, die Ausgestaltung ist weniger genau durch Vorschriften geregelt, in den diversen Methodenlehrbüchern jedoch durch mannigfaltige Beispielvorbilder inspiriert.7) Ebenso verhält es sich mit einzelnen Bestandteilen der GTM. So sind für das Verfahren des Memo-Schreibens zwar bestimmte verbindliche (Mindest-)Anforderungen zu erfüllen, z.B. Nennung des Entstehungsdatums, Benennung eines Themas (Überschrift) sowie eines Referenzpunkts (in den Daten, im Erleben der Forschenden o.Ä.), es ist in seiner Ausgestaltung, seinem Umfang, seiner literarischen Form etc. allerdings sehr frei gestaltbar ("informelles Schreiben") (BREUER et al. 2019, S.169). Das sogenannte "Kodierparadigma" bzw. das paradigmatische Modell im Lehrbuch von STRAUSS und CORBIN (1998 [1996]) lässt sich als ein Vorschlag verstehen, über die Struktur der gewonnenen Daten und Konzeptideen in einer bestimmten Weise nachzudenken, sich von dieser Modellvorgabe inspirieren zu lassen – es ist jedoch nicht als obligatorische Richtlinie gedacht. [34]

Im Fokus der GTM-Methodologie steht das Bemühen, die Kreativität der Forscher_innen im Prozess der Theorieentwicklung anzuregen. In einer persönlichen Reflexion resümiert STRAUSS (1991b, o.P.), was er von seinen Gedanken zum Denk- und Forschungsstil der GTM als bedeutsam ansieht:

"I don’t know that my particular career [...] has any message for anybody today. If there is one I would put the emphasis on having a sense of what fits your own style and temperament, what too you want to get from research – and sticking with resolve to that, and quite as important also attempting to manage conditions to maximize your own creativity and warding off or minimizing those that will lessen or destroy it. If qualitative research lines up with those directives, then you do and keep on doing it." [35]

Für das Gelingen des GTM-Forschungsprozesses kommt es also darauf an, das zu beachten, was zum eigenen Stil und Charakter der Forscher_innen-Persönlichkeit passt und das zu maximieren, was die eigene Kreativität fördert und belebt. [36]

Durch Details und Beispielreichtum (Präzision) in der Beschreibung von Vorgehensmöglichkeiten zeichnen sich auch die Methodenbücher von Barney GLASER (1978) und Cathy CHARMAZ (2014) aus. Bezüglich der Präskriptivitäts-Dimension gehen die beiden allerdings auseinander. In einem Interview mit Antony PUDDEPHATT (2006) beschreibt Kathy CHARMAZ die Methoden der Grounded Theory "[...] as a set of principles and practices, not as prescriptions and packages" (S.9). Sie betont deren Flexibilität und nicht deren Regelhaftigkeit. Während CHARMAZ in ihrem konstruktivistischen Verständnis der GTM vorwiegend im Sinne von Vorschlägen und Anregungen für eigenständiges und kreatives Arbeiten von Forscher_innen argumentiert, gibt GLASER (vor allem in seiner späteren Schrift von 1992) sehr dezidierte Richtlinien vor, nach denen Forscher_innen die Dinge richtig und falsch machen können, um sein Kriterium einer Classical Grounded Theory zu treffen (vgl. auch GLASER & HOLTON 2004). [37]

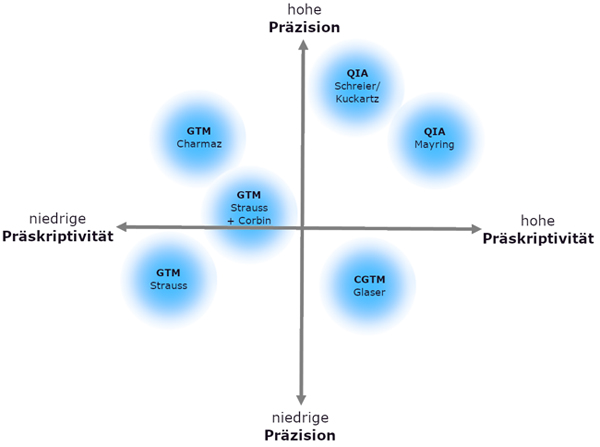

Um unsere Überlegungen bezüglich der Instruktionalitätsprofile unterschiedlicher Varianten der QIA und GTM (bzw. der Instruktionalisierungsprofile der unterschiedlichen Verfahrensbeschreibungen durch ihre Vertreter_innen) mit ihren beiden dimensionalen Komponenten (Präskriptivität und Präzision) zusammenzufassen und zu visualisieren, zeigt Abbildung 1 unsere tentative Einordnung.

Abbildung 1: tentative Einordnung verschiedene Vertreter_innen von Verfahren im Hinblick auf die Instruktionalitätsprofile

(bzw. Instruktionalisierungsprofile) ihrer Methodenbeschreibungen (CGTM steht für Classical Grounded Theory) [38]

5. Gründe für Instruktionalitätsunterschiede zwischen QIA und GTM

Gründe für die unterschiedlichen Instruktionalitätsprofile in den Darstellungen von QIA und GTM (bzw. ihre unterschiedliche Instruktionalisierung durch Methoden-/Lehrbuchautor_innen) sehen wir in den Entstehungsbedingungen der Verfahren, in ihrem jeweiligen Anspruch, für Forschungsnoviz_innen und erfahrene Forscher_innen brauchbar bzw. anwendbar zu sein, sowie in der Forderung, vertrauenswürdige Analyseergebnisse hervorzubringen. [39]

5.1 Entstehungsbedingungen der Verfahren

Der Entwurf und die Entwicklung der GTM und ihrer Methodik entspringt wesentlich der Zusammenarbeit der beiden Gründungsväter GLASER und STRAUSS in den 1960er Jahren im Rahmen von medizinsoziologischen Forschungsprojekten (prototypisch in ihrer Studie zur "Awareness of Dying", GLASER & STRAUSS 1965). Der programmatische Klassiker aus dieser Entstehungszeit ("The Discovery of Grounded Theory", GLASER & STRAUSS 1967) lässt sich als ein Manifest des methodologischen Ansatzes (mit hochgradiger Präskriptivität) auffassen. Hinsichtlich einer Explikation des Regelwerks, was unter dieser Methodik konkret zu tun ist, hat das Buch demgegenüber nicht viel zu bieten (niedrige Präzision). Damalige Studierende, die sich den Forschungsstil aneignen wollten, mussten dies in Forschungswerkstätten von GLASER und STRAUSS tun. Erst eine geraume Weile später kamen methodologische bzw. methodische Lehrbücher der beiden Gründungsprotagonisten heraus (GLASER 1978; STRAUSS 1987). Darin wurde der Ansatz ausgearbeitet und fixiert (Präzision). Dies geschah im weiteren Verlauf auch durch die GTM-Vertreter_innen der zweiten Generation, u.a. durch Juliet CORBIN mit Anselm STRAUSS (1996), Kathy CHARMAZ (2006, 2014), Adele CLARKE (2005) und weitere Nachfolger_innen bzw. Paarungen von Autor_innen (BRYANT & CHARMAZ 2007, MEY & MRUCK 2011, MORSE et al. 2009, STRÜBING 2014). Die Werkzeug-Angebote sind in diesem Zusammenhang zunehmend detailliert ausgearbeitet worden, das Spektrum an wählbaren "zulässigen" Vorgehensvarianten wurde vergrößert, eine Diversifikation von GTM-Konzeptionen auch hinsichtlich philosophischer Hintergründe hat sich entwickelt (z.B. Konstruktivismus, postmoderne Denkweisen). Eine Ausnahme besteht allerdings: GLASER (1992) hat sich entschieden von einer Verweichlichung des (später) von ihm als klassisch bezeichneten, strikt empiristischen GTM-Ansatzes distanziert und wehrte sich gegen die Vereinnahmung "seiner" Methodologie durch Autor_innen einer – in seinen Augen – gänzlich anderen Denkhaltung (GLASER 2004). Er hat eine eigene Einrichtung, The Grounded Theory Institute, gegründet, in dem er die von ihm als konstitutiv erachteten Prinzipien – präskriptiv – hochhält, und er hat und pflegt seine eigene Anhänger_innenschaft (BREUER et al. 2019). [40]

Die QIA ist aus einer kritischen Auseinandersetzung mit der quantitativen Inhaltsanalyse heraus entstanden. Methodenlehrbücher wie das von MAYRING (2015) oder SCHREIER (2012) verweisen zwar auch auf Wurzeln in der Hermeneutik bzw. im interpretativen Paradigma der Sozialwissenschaften, die QIA ist nichtsdestoweniger stark beeinflusst von einem quantitativen Forschungsansatz, bei dem die Replizierbarkeit des methodischen Vorgehens einen zentralen Stellenwert einnimmt (MAYRING 2015). Die klassische Inhaltsanalyse wird angewandt, wenn der Sachverhalt es erlaubt, schnell zu einem kulturell geteilten Verständnis zu kommen. Darunter fallen Bedeutungszuschreibungen, die durch Konventionen bereits standardisiert sind (SCHREIER 2012). Ihre Systematik und ihren Regelcharakter hat die QIA aus der quantitativen IA "geerbt". MAYRING beispielsweise geht es bei seinem Ansatz grundsätzlich darum, die "[...] Stärken der quantitativen Inhaltsanalyse beizubehalten und auf ihrem Hintergrund Verfahren systematischer qualitativ orientierter Textanalyse zu entwickeln" (2015, S.50). KUCKARTZ (2016) stellt fest, dass der Unterschied zwischen der Inhaltsanalyse nach FRÜH (2004) und der von MAYRING (2015) beschriebenen QIA, die letzten Endes auch auf die (statistische) Häufigkeitsauswertung der gebildeten Kategorien hinausläuft, gering zu sein scheint. Wie bereits in Abschnitt 4 erläutert, unterscheiden sich demgegenüber die Ansätze von KUCKARTZ (2016) und SCHREIER (2012) – gerade auch im Hinblick auf ihre Präskriptivität. Einige Vertreter_innen der QIA stellen ihr "quantitatives Erbe" zunehmend infrage und versuchen, das Verfahren stärker an grundlegenden Prinzipien der qualitativen Forschung auszurichten. Dies dürfte auch in Zukunft Veränderungen ihrer Instruktionalitätsprofile mit sich bringen (Abschnitt 6). [41]

5.2 Forschungsanleitungen für Noviz_innen und für erfahrene Forschende

Die für die Anleitung der Forschungspraxis passende Instruktionalität qualitativer Verfahren hängt mit den Fähigkeiten, Haltungen und Erwartungen der Wissenschaftler_innen zusammen, die die Verfahren anwenden (wollen). Das Ausmaß ihrer Forschungserfahrung spielt hierbei eine große Rolle. Für Noviz_innen sind demnach andere Anleitungen passender als für erfahrene Forscher_innen. Hier ergibt sich eine Korrespondenz zu den Darstellungen der beiden methodischen Prozeduren: Während die Anwendung der QIA ein schrittweises Befolgen, Erstellen und erneutes Befolgen von konkreten und (mehr oder weniger) verbindlichen Handlungsvorschriften verlangt, sind die Präsentationen der GTM durch eine stärkere Orientierung an Faust- oder Daumenregeln und eine Ausrichtung auf das Sich-zu-eigen-Machen eines bestimmten Denk- und Handlungsstils gekennzeichnet. [42]

Methodenlehrbücher richten sich typischerweise an Noviz_innen und Unerfahrene, wobei es hierbei gewisse Nuancierungen gibt, die etwas mit den Dimensionen Präzision und Präskriptivität zu tun haben. Die Methodenlehrbücher der QIA werden von ihren Autor_innen als "umfassende Anleitung" (MAYRING 2015, S.10), "anwendungsbezogene Anleitung" (KUCKARTZ 2016, S.5) oder "hands-on textbook" (SCHREIER 2012, S.vii) verstanden – also eine Art praxisorientierter Leitfaden, der Forscher_innen durch die Schritte des Forschungsprozesses führt. Margrit SCHREIER benennt im Vorwort ihres forschungspraxis-orientierten Standardwerks Noviz_innen als Hauptadressat_innen ihres Lehrbuchs:

"In each class, students were asking me similar 'how to' questions. At first, I kept on thinking: If there only was a textbook I could use! And gradually, this turned into: I must get down to it and write that textbook! So this is what this book is meant to be: a hands-on textbook, guiding students and other researchers through the process of conducting their own QCA [qualitative content analysis]" (a.a.O.). [43]

Eine ähnliche Ausrichtung beschreibt Udo KUCKARTZ (2016) in seinem Methodenlehrbuch. Er verfolgt das Ziel, die Unsicherheit von Student_innen und Promovend_innen bei der Auswertung qualitativer Daten zu reduzieren. Forscher_innen am Beginn ihrer selbständigen Forschungslaufbahn können ihre ersten Projekte im Rahmen solcher QIA-Präsentationen durch präzise dargestellte und mit Verbindlichkeit versehene Regelwerke anleiten lassen und absichern (WOLLNY & MARX 2009). Forscher_innen, die um Orientierung und Unsicherheitsreduktion bemüht sind, werden sich, sofern sie eine Wahl zwischen unterschiedlichen methodischen Ansätzen haben, vermutlich häufiger für eine Variante der QIA als der GTM entscheiden, da der dort gebotene Grad an Präzision der Lehrbuchanleitungen ihren Bedürfnissen entgegenkommt, und weil sie sich hier von äußeren Regeln (Präskriptivität und Präzision; Feld a in Tabelle 1) anleiten lassen und sich durch ihre Anwendung absichern können (a.a.O.). [44]

Für die Vermittlung der GTM an Noviz_innen galt von Anfang an das Lernen am Modell, durch Beobachtung und Mittun im sozialwissenschaftlichen Laboratorium in einer überschaubaren Gruppe, als Aneignungsverfahren der Wahl. Forscher_innen lernten, indem sie den Meister_innen über die Schultern schauten und in deren Projekten am Codieren teilnahmen. Dabei wurden weniger verallgemeinerbare Regelwerke erstellt und angewendet, als vielmehr projektbezogene Problemlösungen entwickelt. Die später entstandenen lehrbuchförmigen Anleitungen der GTM sind variabel in Bezug auf ihre Instruktionalität: Es gibt Texte, mit denen sich die Autor_innen eher an unerfahrene und dadurch mitunter unsichere Rezipient_innen richten, in denen der Präzisionsgrad der Instruktion stärker gemacht wird – mitunter auch begleitet von einem strikteren Vorschriftenwesen mit höherer Präskriptivität. Es gibt allerdings auch solche Präsentationen, die auf ein gewisses Maß an Souveränität und Eigenständigkeit der Protagonist_innen zugeschnitten sind, stärker gekennzeichnet durch Faust- und Daumenregeln sowie inspirierende Beispiele, die zum eigenen Denken und Gestalten anregen sollen. [45]

HILDENBRANDT (2004, S.185) bringt die Zielgruppen für Verfahren mit unterschiedlichen Instruktionalitätsprofilen in Methodenlehrbücher über die GTM folgendermaßen zum Ausdruck:

"Studierende mit wenig Sicherheit im Forschungsprozeß und Forscher mit prekären wissenschaftlichen Grundlagen beziehen sich eher auf 'Grounded Theory: Grundlagen qualitativer Sozialforschung' (Strauss und Corbin 1996), das ihnen Handwerksregeln als Ersatz für Kreativität zu versprechen scheint, als auf 'Grundlagen qualitativer Sozialforschung' (Strauss 1991), in welchem methodologische Reflexionen, Beispiele und einige wenige Faustregeln einander abwechseln und der Leser seinen eigenen Weg in der Bearbeitung seines Forschungsthemas finden muß." [46]

5.3 Nachvollziehbarkeit der Ergebnisse

In Methodenbüchern über die GTM wird die persönliche Verwicklung der Forscher_innen in ihre Untersuchungsanliegen thematisiert, so bereits von GLASER und STRAUSS (1965) bei ihrer Untersuchung von Sterbeprozessen. Die Subjektivität und Perspektivität der Forscher_innen wird als Bedingung der Forschungsarbeit anerkannt. Unterschiedlich ist allerdings das Bemühen, diese Charakteristik in den Forschungsprozess explizit und als potenziell produktives Werkzeug einzubeziehen (BREUER et al. 2019). Forschung wird als eine Form von Arbeit aufgefasst, die von leibhaftigen Personen unter speziellen Voraussetzungen und Bedingungen ausgeführt wird (STRAUSS 1991a [1987]). Aus dieser Sicht wird nahe gelegt und anerkannt, dass die Person und Persönlichkeit der Forscher_innen in ihrer Vorgehensweise und ihren Produkten zur Geltung und zum Ausdruck kommt und differente Sichtweisen epistemologischen Wert besitzen. Dies muss allerdings erkenntnistheoretisch gerahmt werden – etwa durch konstruktivistische bzw. perspektivistische Ansätze (CHARMAZ 2006, 2014). [47]

Demgegenüber wird in der Literatur zur QIA sehr viel Wert auf die Herstellung von Instruktionen zur Nachvollziehbarmachung des Kategoriensystems mithilfe eines Codierleitfadens gelegt. Vertreter_innen der QIA wollen das Verfahren durch diese Praxis der Regelgeleitetheit gegen den – u.a. von quantitativen Forscher_innen erhobenen – Vorwurf der Vorgehensbeliebigkeit schützen. Laut MAYRING (2015) soll so ermöglicht werden, dass andere Forscher_innen eine QIA-Analyse nicht nur verstehen und nachvollziehen, sondern auch wiederholen und überprüfen können. Die Nachvollziehbarkeit wird häufig unter dem Gütekriterium der Reliabilität gefasst. Auch wenn in Methodenlehrbüchern zur QIA weitere Gütekriterien diskutiert werden, nimmt die Reliabilitätsprüfung einen hervorgehobenen Platz ein (KUCKARTZ 2016; MAYRING 2015; SCHREIER 2012). Dies mündet im Anspruch einiger Vertreter_innen der QIA auf Prüfung einer Intercoder_innen-Übereinstimmung, um die Zuverlässigkeit der Auswertung (Codierung) bzw. ihre Konsistenz transparent zu machen (MAYRING 2015).8) Die QIA ist also auf Konsistenz und Konvergenz in den Interpretationen von Codierenden ausgerichtet, sowohl innerhalb einer Person zwischen zwei Zeitpunkten als auch zwischen zwei Personen (SCHREIER 2012). Margrit SCHREIER konzeptualisiert die Konsistenz von Deutungen als ein Kriterium, das einen zentralen Aspekt der Güte von Erhebungsinstrumenten darstellt. Die Konsistenz eines Codierleitfadens wird durch wiederholte Codierdurchgänge (durch die gleiche oder eine andere Forschungsperson) hergestellt und überprüft. Die individuelle Sichtweise einer Forschungsperson auf einen Gegenstand wird dabei nicht negiert. Sie spielt eine gewisse Rolle bei der Entwicklung des Codierleitfadens dahingehend, dass Forschende in Ausdeutung der Forschungsfrage selbst entscheiden können, welche Aspekte des Materials sie zu Kategorien machen. Ist der Codierleitfaden erstellt, wird er auf das gesamte Datenmaterial angewendet, wobei eine intersubjektiv-konsensuelle Lesart angestrebt wird. [48]

Die Vorstellungen, wie diese Konsistenz nun überprüft werden soll, divergieren zwischen unterschiedlichen Vertreter_innen der QIA. Bei MAYRING wird ein solcher Anspruch als "intersubjektive Nachprüfbarkeit" formuliert (2015, S.13). Er geht offenbar von einer Replizierbarkeit des Vorgehens aus. An anderer Stelle heißt es: "Die Systematik sollte so beschrieben sein, dass ein zweiter Auswerter die Analyse ähnlich durchführen kann" (S.51). Noch stärker in diese Richtung positionieren sich WOLLNY und MARX (2009), wenn sie schreiben: "So entspricht die Berechnung der Intercoder-Reliabilität zur Sicherung der Güte der Ergebnisse (Vermeidung zu großer Varianzen im Kategoriensystem) der Interrater-Reliabilität quantitativer Forschung und ist im Rahmen inhaltsanalytischer Forschung obligat" (S.468: unsere Hervorhebung). Darauf folgt ihre Empfehlung, die Intercoder_innen-Reliabilität anhand quantitativer Maße (z.B. eines Kappa-Koeffizienten) zu bestimmen. Sie geben in diesem Zusammenhang einen quantitativen Schwellenwert vor, der dabei erreicht werden soll. SCHREIER (2012) empfiehlt eine Zweitcodierung der Textmaterialien im Sinne eines konsensuellen Codierens zur Konsistenzherstellung. Das gibt sie jedoch nicht als unverzichtbar vor und legt nahe, die Überprüfung auf Teile der Codierung zu beschränken. KUCKARTZ (2016) beschreibt beide Verfahren und stellt eine quantitative Berechnung eines Übereinstimmungskoeffizienten frei, zeigt allerdings Vorteile, Grenzen der Umsetzbarkeit und publikationspragmatische Zwänge auf. Bei der Prüfung der Intercoder_innen-Reliabilität scheint dabei nach unserem Verständnis von der Annahme ausgegangen zu werden, dass den Ergebnissen eine größere Überzeugungskraft zugeschrieben wird, wenn mehrere Codierende das Material auf dieselbe Art und Weise verstanden und kategorial eingeordnet haben. [49]

Gegenüber diesem technischen Herangehen bei der Güteprüfung in der QIA schlagen CORBIN und STRAUSS (1990) Evaluationskriterien vor, die sich sowohl auf den Forschungsprozess als auch auf die Forschungsergebnisse beziehen. CHO und LEE (2014, S.14) fassen sie folgendermaßen zusammen: "[...] rigor in the coding and research process, quality of concepts, systematic relatedness among concepts, conceptual density, range of variations and specifity, significance of theoretical findings, and theoretical sensitivity". Im GTM-Rahmen wird außerdem versucht, (Deutungs-)Unterschiede an die Subjektivität der Forscher_innen/Codierer_innen, an ihre Erkenntnisstandpunkte rückzubinden und so die Unterschiedlichkeit von Interpretationen über die Charakteristik der deutenden Subjekte zu erklären. Es wird hier stärker auf das methoden-konstitutive Konzept des Vergleichens, des Kontrastierens, als Erkenntnisheuristik gesetzt (BREUER et al. 2019; CHARMAZ 2006, 2013). Dabei wird in der Zusammenstellung der Daten, also bei der Auswahl von Interviewpartner_innen, Dokumenten, Beobachtungssituationen etc. eine kontrastreiche und multi-perspektivische Untersuchung des Forschungsgegenstandes angestrebt, um die zu entwickelnde Theorie auf eine möglichst breite empirische Basis zu stellen und eingefahrene Sichtweisen zu lockern. Darüber hinaus werden in der Datenanalyse unterschiedliche Lesarten von Daten als erkenntnisproduktiv betrachtet: Diese werden in ihrer jeweiligen Perspektivgebundenheit anerkannt und miteinander verglichen, u.U. ohne dass eine Entscheidung für eine (überlegene, bessere, passendere oder konsensfähige) Lesart getroffen werden muss oder eine Nivellierung im Sinne des Konsistenz-/Konvergenz-Strebens stattfindet. [50]

Die gleichzeitige Verfügbarkeit der QIA und GTM im sozialwissenschaftlichen Methodenrepertoire führt dazu, dass von Forschenden in ihren Projekten und zunehmend auch von Methodenbuchautor_innen in ihren Forschungsanleitungen Bausteine des einen Verfahrens in ein anderes Verfahren integriert werden. Viele Aspekte der Diskussion über die Kombination qualitativer und quantitativer Methoden (Mixed Methods) sind auf die Verknüpfung von Elementen verschiedener qualitativer Herangehensweisen übertragbar, insbesondere im Hinblick auf die Gütekriterien solcher Designs (KUCKARTZ 2014; SCHREIER & ODAĞ 2017). [51]

Eine programmatische Verbindung von QIA und GTM nennen wir Hybridverfahren. Ein Hybridverfahren hebt sich insofern von einem "muddling of methods" (HSIEH & SHANNON 2005, S.1278) – an dem berechtigterweise Kritik geübt wird – ab, als die Kombination explizit gemacht, methodisch/methodologisch reflektiert und die geänderte Verfahrensweise fallübergreifend/allgemein beschrieben wird.9) [52]

Verbindungen zwischen Bausteinen der GTM und der QIA sind in vielerlei Hinsicht denkbar. Es ist möglich, die Sampling-Prozedur in der GTM sowohl in der Fallauswahl als auch in der Bestimmung der theoretischen Sättigung mit einer QIA zu koppeln. Nach SCHREIER (2012, S.36) ist es unproblematisch, ein "cyclic design" mit der fortlaufenden Erstellung und Revision eines Codierleitfadens zu kombinieren. Auch durch die Arbeit mit kontrastiven Fällen kann die dateninspirierte Kategorienbildung in der QIA bereichert und das Bilden von theoretischen Kategorien gefördert werden. KUCKARTZ (2016) und SCHREIER (2012) inkorporieren beispielsweise das offene Codieren in das Repertoire der Kategorienentwicklung in der QIA – auch mit Rückgriff auf sogenannte In-vivo-Codes. SCHREIER betonte laut Tagungsbericht der Veranstaltung "Qualitative Inhaltsanalyse – and beyond?", dass gerade die Analyse von Zusammenhängen zwischen Kategorien eines Kategoriensystems, die in der GTM eine wichtige Rolle spielt, in der QIA stärker verfolgt werden sollte (JANSSEN et al. 2017). Derartige Hybridverfahren bzw. Integrationen einzelner Bausteine der einen Methode in die andere können sinnvoll sein. Es gilt aber zu bedenken, wie es in dem erwähnten Tagungsbericht heißt, dass "bei einer etwaigen Übernahme von Elementen des Kategorienbegriffs aus der GTM in der Konsequenz Standards und Systematiken der qualitativen Inhaltsanalyse an bestimmten Stellen aufgelöst werden müssten" (§18). Es stellen sich Fragen wie: Welches Verfahren wird als Leitmethodik gesetzt? Werden Bausteine der GTM in die QIA übernommen oder umgekehrt? Welches Instruktionalitätsprofil soll einem Hybridverfahren gegeben werden? Solche Entscheidungen sind begründungsbedürftig und können u.a. davon beeinflusst sein, welche Anschlussfähigkeit zur quantitativen Forschung gewünscht ist (z.B. im Rahmen von Mixed-Methods-Vorhaben). [53]

Unsere Idee der zweidimensional bestimmten Konzeption von Instruktionalität über Präskriptivität und Präzision des Vorgehens hat sich beim Vergleich von QIA und GTM als brauchbar und bereichernd erwiesen. Die Instruktionalitätsprofile der beiden Verfahren und ihrer jeweiligen Varianten und Darstellungen in Methodenlehrbüchern lassen sich mit dieser konzeptionellen Ausdifferenzierung anregend reflektieren. Forscher_innen können bei ihrer Entscheidung über die Verwendung einer Forschungsmethode auch die Instruktionalitätsprofile einer Methode in Betracht ziehen und deren Passung zu den eigenen Wünschen oder Erfordernissen reflektieren. Nutzer_innen präferieren womöglich in Abhängigkeit von ihrem Vorwissens- und Erfahrungsgrad (bzw. ihrer Methodenkompetenz) unterschiedlich präzise und ausführliche Vorgaben bzw. können unterschiedlich flexibel mit (un-)verbindlichen Handlungsanweisungen umgehen. Da sich die QIA und GTM im Hinblick auf ihre Instruktionalitätsprofile stark unterscheiden, sollte bei der Entwicklung von Hybridmethoden mit Bausteinen aus beiden Forschungsansätzen die Instruktionalität des daraus resultierenden Verfahrens transparent beschrieben werden. [54]

Wir danken David TSCHEBINER, der uns bei der Vorbereitung dieses Beitrags durch die Auswertung einer Textpassage mit der zusammenfassenden QIA nach MAYRING (2015) zum Nachdenken über die Instruktionalitätsprofile der QIA-Methodenlehrbücher angeregt hat. Wir danken Yannick ADAMS für die Formatierung der Abbildung. Wir danken last but not least unseren Reviewer_innen für viele anregende Nachfragen und Hinweise.

1) Die Bezeichnung QIA wird in diesem Beitrag sowohl für die Methode selbst als auch für das Ergebnis der Methode verwendet, im Gegensatz zu den Begriffen Grounded-Theory-Methodologie (GTM) und Grounded Theory, durch die Methode und Ergebnis unterschiedlich bezeichnet werden. <zurück>

2) Wir vertreten die Auffassung, dass die QIA eine qualitative Forschungsmethode ist, auch wenn es Vertreter_innen der qualitativen Forschung gibt, die ihr die Zugehörigkeit zu den qualitativen Methoden absprechen würden. Wir stimmen der Argumentation von SCHREIER (2012) zu, dass die QIA mit anderen qualitativen Verfahren genügend Gemeinsamkeiten hat, um sie als qualitative Methode aufzufassen, wenngleich sie auch eine gewisse Nähe und Anschlussfähigkeit zur quantitativen Forschung aufweist. <zurück>

3) Den Begriff der Präskriptivität leiten wir von dem Adjektiv "präskriptiv" ab: bestimmte Normen festlegend, vorschreibend. <zurück>

4) Kontexte gehobener bzw. hoher Präskriptivität von Regelwerken können wir beispielsweise in der Kommunikation mit technischen Artefakten (Software-Installationsvorgaben, App-Bedienung etc.), im Umgang mit Ämtern (Formularvorgaben, Verfahrensvorschriften) oder in der Arbeitswelt (Einhaltung des Dienstwegs, gesetzliche Vorgaben für die Arbeitssicherheit, Tarifvereinbarungen, Kommandostrukturen beim Militär etc.) vorfinden. <zurück>

5) Wir kennen das aus alltagsweltlichen Zusammenhängen, wenn wir uns beispielsweise beim Kochen und Backen an Rezepten orientieren: Es gibt Rezepte für Fortgeschrittene, die eher vage formuliert sind und viele Variationsmöglichkeiten offen lassen (z.B.: eine Prise Salz, etwas Zucker, Backen bis es "stockt" usw.) oder Rezepte mit YouTube-Videos für Koch-Noviz_innen, bei denen jeder Schritt exakt und präzise vorgeben und sogar visualisiert (man nehme 20g Zucker, 150g Mehl ...) und eine präzise Temperaturmessung im Backofen empfohlen wird. Daran wird deutlich, dass Nutzer_innen in Abhängigkeit von ihrem Erfahrungsgrad unterschiedlich präzise und ausführliche Vorgaben benötigen bzw. unterschiedlich flexibel mit Handlungsanweisungen umgehen können und wollen. <zurück>

6) Es geht in der strukturierenden QIA darum, Datenmaterial nach inhaltlichen Aspekten (Themen) zu extrahieren und zusammenzufassen. Themen werden zu Kategorien (weiter-)entwickelt, in einem Kategoriensystem konzeptualisiert und auf das Datenmaterial angewendet. Für SCHREIER (2014, §7) stellt die inhaltlich-strukturierende Inhaltsanalyse den "Kern einer qualitativen Inhaltsanalyse" dar. Sie verweist auf zehn weitere Varianten, auf die wir hier nicht weiter eingehen werden, darunter die zusammenfassende, skalierende oder typenbildende Inhaltsanalyse, die auch bei MAYRING (2015) beschrieben werden. <zurück>

7) Historiker_innen, die Quellen analysieren, müssen die Vorgaben des Theoretical Sampling frei umsetzen, denn sie sind auf bereits vorhandene Dokumente angewiesen. Sie können ihre Daten nur aus vorgefundenen Quellen zusammenstellen. Ihre Fallauswahl ist so deutlich eingeschränkter, als es bei Sozialwissenschaftler_innen der Fall ist, die Interviewpartner_innen nach bestimmten Kriterien wählen und Daten selbst produzieren können. <zurück>

8) Die Reliabilitätsbestimmung durch Übereinstimmungsmessung ist ein Erbe der quantitativ orientierten Inhaltsanalyse. In der integrativen Inhaltsanalyse nach FRÜH (2015) beispielsweise ist der Gedanke der Subjekt-/Person-Abhängigkeit des Forschungsprozesses eine Störbedingung, die kontrolliert, ausgeschaltet oder minimiert werden soll. <zurück>

9) Wir wollen mit dem Begriff Hybridverfahren explizit nicht ein Label für Forschungsarbeiten zur Verfügung stellen, bei denen eine Diskrepanz zwischen der Behauptung, einen methodischen Ansatz verwendet zu haben und dem tatsächlich berichteten methodischen Vorgehen bzw. der Art des Ergebnisses besteht, wie das z.B. von SANDELOWSKI und BARROSO (2003) beschrieben wurde. Dabei kann es sich z.B. um Arbeiten handeln, die ihr Vorgehen modifizieren, ohne zu spezifizieren, in welchen Schritten von einem Verfahren abgewichen wurde (WOLLNY & MARX 2009). <zurück>

Breuer, Franz; Muckel, Petra & Dieris, Barbara (2019). Reflexive Grounded Theory. Eine Einführung für die Forschungspraxis (4., durchges. u. akt. Aufl.). Wiesbaden: Springer VS.

Bryant, Antony & Charmaz, Kathy (Hrsg.) (2007). The Sage handbook of grounded theory. London: Sage.

Charmaz, Kathy (2006). Constructing grounded theory: A practical guide through qualitative analysis. London: Sage.

Charmaz, Kathy (2014). Constructing grounded theory (2. Aufl.). London: Sage.

Cho, Ji Y. & Lee, Eun-Hee (2014). Reducing confusion about grounded theory and qualitative content analysis: Similarities and differences. The Qualitative Report, 19(32), 1-20, https://nsuworks.nova.edu/tqr/vol19/iss32/2 [Zugriff: 21. Oktober 2019].

Clarke, Adele E. (2005). Situational analysis: Grounded theory after the postmodern turn. London: Sage.

Corbin, Juliet & Strauss, Anselm L. (1990). Grounded theory research: Procedures, canons, and evaluative criteria. Qualitative Sociology, 13(1), 3-21.

Früh, Werner (2004). Inhaltsanalyse: Theorie und Praxis (5. Aufl.). Konstanz: UVK.

Früh, Werner (2015). Inhaltsanalyse: Theorie und Praxis (8. Aufl.). Konstanz und München: UVK.

Gläser, Jochen & Laudel, Grit (2013). Life with and without coding: Two methods for early-stage data analysis in qualitative research aiming at causal explanations. Forum Qualitative Sozialforschung / Forum: Qualitative Social Research, 14(2), Art. 5, http://dx.doi.org/10.17169/fqs-14.2.1886 [Zugriff: 5. August 2019].

Glaser, Barney G. (1978). Theoretical sensitivity: Advances in the methodology of grounded theory. Mill Valley, CA: Sociology Press.

Glaser, Barney G. (1992). Emergence vs. forcing. Basics of grounded theory analysis. Mill Valley, CA: Sociology Press.

Glaser, Barney G. (2001). The Grounded theory perspective: Conceptualization contrasted with description. Mill Valley, CA: Sociology Press.

Glaser, Barney G. (2004). "Naturalist inquiry" and grounded theory. Forum Qualitative Sozialforschung / Forum: Qualitative Social Research, 5(1), Art. 7, http://dx.doi.org/10.17169/fqs-5.1.652 [Zugriff: 16. Dezember 2019].

Glaser, Barney G. (2013). No preconceptions: The grounded theory dictum. Mill Valley, CA: Sociology Press.

Glaser, Barney G. in Zusammenarbeit mit Judith Holton (2004). Remodeling grounded theory. Forum Qualitative Sozialforschung / Forum: Qualitative Social Research, 5(2), Art. 4, http://dx.doi.org/10.17169/fqs-5.2.607 [Zugriff: 16. Dezember 2019].

Glaser, Barney G. & Strauss, Anselm L. (1965). Awareness of dying. Chicago, IL: Aldine.

Glaser, Barney G. & Strauss, Anselm L. (1967). The discovery of grounded theory. Chicago, IL: Aldine.

Hildenbrandt, Bruno (2004). Gemeinsames Ziel, verschiedene Wege: Grounded Theory und Objektive Hermeneutik im Vergleich. Sozialer Sinn, 2, 177-194.

Hitzler, Ronald (2001). Künstliche Dummheit: Zur Differenz zwischen alltäglichem und soziologischem Wissen. In Heike Franz, Werner Kogge, Torger Möller & Torsten Wilholt (Hrsg.), Wissensgesellschaft. Transformationen im Verhältnis von Wissenschaft und Alltag. Tagung vom 13.-14. Juli 2000 an der Universität Bielelefeld, IWT-Paper 25, https://pub.uni-bielefeld.de/download/2305319/2305334 [Zugriff: 18. Dezember 2019].

Hitzler, Ronald & Eisewicht, Paul (2016). Lebensweltanalytische Ethnographie – im Anschluss an Anne Honer. Weinheim: Beltz Juventa.

Hopf, Christel & Schmidt, Christiane (1993). Zum Verhältnis von innerfamilialen sozialen Erfahrungen, Persönlichkeitsentwicklung und politischen Orientierungen: Dokumentation und Erörterung des methodischen Vorgehens in einer Studie zu diesem Thema, http://nbn-resolving.de/urn:nbn:de:0168-ssoar-456148 [Zugriff: 19. Juli 2019].

Hsieh, Hsiu-Fang & Shannon, Sarah E. (2005). Three approaches to qualitative content analysis. Qualitative Health Research, 15, 1277-1288.

Janssen, Markus; Stamann, Christoph; Krug, Yvonne & Negele, Christina (2017). Tagungsbericht: Qualitative Inhaltsanalyse – and beyond?. Forum Qualitative Sozialforschung / Forum: Qualitative Social Research, 18(2), Art. 7, http://dx.doi.org/10.17169/fqs-18.2.2812 [Zugriff: 5. August 2019].

Kelle, Udo (2005). "Emergence" vs. "forcing" of empirical data? A crucial problem of "grounded theory" reconsidered. Forum Qualitative Sozialforschung / Forum: Qualitative Social Research, 6(2), Art. 27, http://dx.doi.org/10.17169/fqs-6.2.467 [Zugriff: 5. August 2019].

Kuckartz, Udo (2014). Mixed Methods. Methodologie, Forschungsdesigns und Analyseverfahren. Wiesbaden: Springer VS.

Kuckartz, Udo (2016). Qualitative Inhaltsanalyse. Methoden, Praxis, Computerunterstützung (3. Aufl.). Weinheim: Beltz Juventa.

Legewie, Heiner & Schervier-Legewie, Barbara (2004). "Forschung ist harte Arbeit, es ist immer ein Stück Leiden damit verbunden. Deshalb muss es auf der anderen Seite Spaß machen". Anselm Strauss im Interview mit Heiner Legewie und Barbara Schervier-Legewie. Forum Qualitative Sozialforschung / Forum: Qualitative Social Research, 5(3), Art. 22., http://dx.doi.org/10.17169/fqs-5.3.562 [Zugriff: 5. August 2019].

Mayring, Philipp (2015). Qualitative Inhaltsanalyse. Grundlagen und Techniken (12. Aufl.). Weinheim: Beltz.

Mey, Günter & Dietrich, Marc (2016). Vom Text zum Bild – Überlegungen zu einer visuellen Grounded-Theory-Methodologie. Forum Qualitative Sozialforschung / Forum: Qualitative Social Research, 17(2), Art. 2, http://dx.doi.org/10.17169/fqs-17.2.2535 [Zugriff: 5. August 2019].

Mey, Günter & Mruck, Katja (Hrsg.) (2011). Grounded Theory Reader. Positionen und Kontroversen zur Grounded Theory (2. Aufl.). Wiesbaden: VS Verlag für Sozialwissenschaften.

Morse, Janice, Stern, Phyllis Noerager, Corbin, Juliet, Bowers, Barbara, Charmaz, Kathy, Clarke, Adele E. (2009). Developing grounded theory. The second generation. Left Coast Press.

Muckel, Petra (2011). Die Entwicklung von Kategorien mit der Methode der Grounded Theory. In Günther Mey & Katja Mruck (Hrsg.), Grounded Theory Reader (2., akt. u. erw. Aufl., S.333-352). Wiesbaden: VS Verlag für Sozialwissenschaften.

Puddephatt, Antony J. (2006). An interview with Kathy Charmaz: On constructing grounded theory. Qualitative Sociology Review, II(3), 5-20, http://www.qualitativesociologyreview.org/ENG/Volume5/QSR_2_3_Interview.pdf [Zugriff: 9. Dezember 2019].

Saldaña, Johnny (2016). The coding manual for qualitative researchers (3. Aufl.). London: Sage.

Sandelowski, Margarete & Barroso, Julie (2003). Classifying the findings in qualitative studies. Qualitative Health Research, 13(7), 905-923.

Schreier, Margrit (2012). Qualitative content analysis in practice. London: Sage.

Schreier, Margrit (2014). Varianten qualitativer Inhaltsanalyse: Ein Wegweiser im Dickicht der Begrifflichkeiten. Forum Qualitative Sozialforschung / Forum: Qualitative Social Research, 15(1), Art. 18, http://dx.doi.org/10.17169/fqs-15.1.2043 [Zugriff: 5. August 2019].

Schreier, Margrit & Odağ, Özen (2017). Mixed-Methods-Forschung in der Psychologie. In Günter Mey & Katja Mruck (Hrsg.), Handbuch Qualitative Forschung in der Psychologie (2., erw. u. akt. Aufl.). Heidelberg: Springer Reference Psychologie.

Stamann, Christoph; Janssen, Markus & Schreier, Margrit (2016). Qualitative Inhaltsanalyse – Versuch einer Begriffsbestimmung und Systematisierung. Forum Qualitative Sozialforschung / Forum: Qualitative Social Research, 1(3), Art. 16, http://dx.doi.org/10.17169/fqs-17.3.2581 [Zugriff: 19. Dezember 2019].

Strauss, Anselm L. (1987). Qualitative analysis for social scientists. New York. NY: Cambridge University Press.

Strauss, Anselm L. (1991a [1987]). Grundlagen qualitativer Sozialforschung. Datenanalyse und Theoriebildung in der empirischen soziologischen Forschung. München: Fink.

Strauss, Anselm L. (1991b). Qualitative family research: A personal history of the development of grounded theory. A Newsletter of the Qualitative Family Research Network, 5(2), http://dne2.ucsf.edu/public/anselmstrauss/pdf/work-grounded_qfr.pdf [Zugriff: 22.Februar 2019].

Strauss, Anselm L. & Corbin, Juliet (1998 [1996]). Grounded Theory. Grundlagen Qualitativer Sozialforschung. Weinheim: Beltz/Psychologie Verlags Union.

Strübing, Jörg (2014). Grounded Theory. Zur sozialtheoretischen und epistemologischen Fundierung eines pragmatistischen Forschungsstils. (3. Aufl.). Wiesbaden: Springer VS.

Wollny, Anja & Marx, Gabriella (2009). Qualitative Sozialforschung – Ausgangspunkte und Ansätze für eine forschende Allgemeinmedizin: Teil 2: Qualitative Inhaltsanalyse vs. Grounded Theory. Zeitschrift für Allgemeinmedizin, 11, 467-476, https://www.online-zfa.de/archiv/ausgabe/artikel/zfa-11-2009/47576-103238-zfa20090467-qualitative-sozialforschung-ausgangspunkte-und-ansaetze-fuer-eine-forsch/ [Zugriff: 5. August 2019].

Zu den Autorinnen und zum Autor

Katja KÜHLMEYER ist wissenschaftliche Mitarbeiterin am Institut für Ethik, Geschichte und Theorie der Medizin der LMU München. Sie geht qualitativer Forschung in Medizin und Public Health nach und arbeitet dabei insbesondere zu medizin- bzw. Public-Health-ethischen Fragestellungen. Sie unterrichtet Studierende beider Fächer in der qualitativen Inhaltsanalyse. Sie interessiert sich für verschiedene qualitative Forschungsansätze und -methoden und ihre Verbindung mit quantitativer Forschung (Mixed Methods). Sie hat Psychologie in Mainz und Tübingen studiert.

Kontakt:

Dr. Katja Kühlmeyer

Institut für Ethik, Geschichte und Theorie der Medizin

LMU München

Lessingstr. 2

80336 München

Tel.: +49 (0)89-2180-72790

E-Mail: katja.kuehlmeyer@med.lmu.de

Petra MUCKEL studierte Psychologie, Germanistik und Philosophie und arbeitete über viele Jahre an der Carl von Ossietzky Universität Oldenburg und seit 2016 in freier Praxis als Familienrechtsgutachterin. Dabei integriert sie Elemente der GTM in den gutachterlichen Erkenntnis- und Schreibprozess. Sie hat seit Ende der 1980er Jahre, als sie die GTM bei Franz BREUER kennenlernte, in zahlreichen Forschungsprojekten, in der Hochschullehre, in Workshops und Forschungswerkstätten Erfahrungen mit diesem Forschungsstil gesammelt und publiziert sowie an der Elaboration der Reflexiven Grounded Theory mitgewirkt.

Kontakt:

Dr. Petra Muckel

Bürgerbuschweg 47

26127 Oldenburg

E-Mail: petra.muckel@uol.de

Franz BREUER war bis 2014 Professor am Institut für Psychologie der Universität Münster. Seine Themenschwerpunkte der letzten Zeit waren das Altern von und in Familien sowie Vorgänger_innen-Nachfolger_innen-Übergänge in unterschiedlichen sozialen Kontexten. Seit den 1980er Jahren hat er sich methodologisch mit GTM beschäftigt und mit Mitarbeiter_innen die Idee einer Reflexiven Grounded Theory ausgearbeitet. Heute unterrichtet er diesen Forschungsstil in Workshops an unterschiedlichen Universitäten und berät einschlägige Qualifikationsarbeiten und Forschungsprojekte.

Kontakt:

Prof. i.R. Dr. Franz Breuer

Universität Münster

Institut für Psychologie

Fliednerstr. 21

48149 Münster

E-Mail: breuerf@uni-muenster.de

Kühlmeyer, Katja; Muckel, Petra & Breuer, Franz (2020). Qualitative Inhaltsanalysen und Grounded-Theory-Methodologien im Vergleich: Varianten und Profile der "Instruktionalität" qualitativer Auswertungsverfahren [54 Absätze]. Forum Qualitative Sozialforschung / Forum: Qualitative Social Research, 21(1), Art. 22, http://dx.doi.org/10.17169/fqs-21.1.3437.