Volume 7, No. 2, Art. 6 – März 2006

Das Repertory-Grid-Interview als Methode kooperativen Forschungshandelns

Michael Dick

Review Essay:

Martin Fromm (2004). Introduction to the Repertory Grid Interview. Münster: Waxmann, 190 Seiten, ISBN 3-8309-1394-X, EUR 24,90

Martin Fromm & Andreas Bacher (2003-2004). GridSuite 2.1.0 (Software zur Erhebung, Bearbeitung und Auswertung von Repertory-Grid-Interviews). http://www.gridsuite.de/ [Zugriff 31.10.2005], ab 58,- € für die Einzel-Jahreslizenz

Zusammenfassung: Ausgehend von einer Kritik an der Ausrichtung der Methodenausbildung in der Psychologie (in Deutschland) werden die Gegenstandsangemessenheit und die Kooperationsförderlichkeit von Methoden als Kriterien methodischer Professionalität betont. Anschließend wird das Repertory-Grid-Interview als Verfahren vorgestellt, das beiden Kriterien gerecht wird. Das rezensierte Lehrbuch sowie die damit korrespondierende Software stellen eine geeignete Einführung in das Verfahren dar, setzen allerdings eine bereits begründete und im Feld implementierte Fragestellung voraus.

Keywords: Methodenausbildung, Professionalität, Gütekriterien, Repertory-Grid-Interview, Psychologie persönlicher Konstrukte

Inhaltsverzeichnis

1. Methodische Professionalität als Ziel wissenschaftlicher Ausbildung

2. Das Repertory-Grid-Interview als kooperative Forschungsmethode

3. Eine Einführung in die professionelle Handhabung des Repertory-Grid-Interviews

4. Die Software Gridsuite

4.1 Erhebung

4.2 Auswertung und Berechnung

5. Zusammenfassende Bewertung

1. Methodische Professionalität als Ziel wissenschaftlicher Ausbildung

Zu den wichtigsten berufsfeldorientierten Kompetenzen der human- und sozialwissenschaftlichen Disziplinen gehört es, empirische Forschungsmethoden zu beherrschen. Entsprechend hohen Stellenwert genießt besonders in der Psychologie die Methodenausbildung. Diese steht in einem engen Verhältnis zu den Anwendungsfeldern der psychologischen Diagnostik und der experimentellen Forschung. Diagnostik wird dabei im Wesentlichen als standardisiertes Vorgehen auf der Grundlage der klassischen Testtheorie gelehrt (JÄGER 1988; LIENERT & RAATZ 1994), die Konstruktion von Fragebögen dient in der Regel ebenfalls dem Ziel standardisierter Untersuchungen (MUMMENDEY 1995). Experimentelle Verfahren richten sich auf allgemeingültige Aussagen über menschliches Verhalten. Sie setzen eine detailliert operationalisierte und bereits umfassend geprüfte Theorie voraus, aus der Hypothesen abgeleitet werden, die mit hinreichender Wahrscheinlichkeit empirisch bestätigt werden können (BORTZ 2005). So liegt das Schwergewicht auch dort auf statistischen bzw. mathematischen Verfahren (BORTZ & DÖRING 2002). [1]

In jüngerer Zeit wächst allerdings die Kritik an einem zu eng am Ritual der Testung von Null-Hypothesen orientierten empirischen Vorgehen in der Psychologie (GIGERENZER 2004; THOMPSON 2004). Es wird für Vorgehensweisen plädiert, die der sozialen Realität näher kommen und die Forschung nicht zu sehr von strengen mathematischen Voraussetzungen abhängig machen. In klinischen Studien werden zunehmend auch Verfahren verwendet, die mit kleineren Fallzahlen und geringeren Voraussetzungen arbeiten (BORTZ & LIENERT 2003; FIDLER, CUMMING, BURGMAN & THOMASON 2004). [2]

Denn die methodische Ausbildung in der Psychologie entspricht nicht den Anforderungen, die in vielen beruflichen Tätigkeitsfeldern an empirische Forschung gerichtet werden. Häufiger als um die Verfeinerung kontextunabhängiger Theorien geht es darum, Handlungsbedingungen von Menschen kennen zu lernen und besser zu verstehen, insbesondere in Feldern, die unübersichtlich und einem starken Wandel unterworfen sind – etwa in der Markt- und Konsumforschung, der Arbeits- und Organisationsforschung oder der Umweltpsychologie. [3]

Gefragt sind hier öffnende, sensitive und prozessorientierte Verfahren (DICK 1996), die zunächst einen Zugang zum Feld ermöglichen, um dieses dann abbilden und reflexiv strukturieren zu können. Entdeckende, heuristische und deskriptive Vorgehensweisen sind hierzu meist sinnvoller als prüfende Statistik. Die Theorien, die diese voraussetzen und hervorbringen, haben eine kürzere Reichweite, sind dafür aber den Lebensumständen im Feld gegenüber adaptiver. Sie sind dem Gegenstand angemessen ("grounded", GLASER & STRAUSS 1967) und werden nicht als Beweisgrundlage verwendet, sondern als öffnende Konzepte ("sensitizing concepts"; BLUMER 1980). Kriterium einer Methode ist nicht ihre Robustheit, sondern ihre theoretische Sensitivität (GLASER 1978). [4]

Ein solche Ausrichtung hat in der Psychologie als idiographisches Vorgehen (PETERMANN 1988) durchaus Tradition, etwa in der die Psychologie der Wahrnehmung stark beeinflussenden Gestaltpsychologie (METZGER 1941), in der ökologischen Psychologie (GRAUMANN 1976; KAMINSKI 1986), in der Entwicklungspsychologie (THOMAE 1989) oder in der Sozialpsychologie (KEUPP 1993). Allerdings ist dieses Vorgehen methodisch nie in gleicher Weise wie das statistische Vorgehen expliziert und verfeinert worden. Erst seit den 90er Jahren werden instruktive und detailliertere methodische Einführungen auch in explizit psychologischer Ausrichtung vorgelegt (BREUER 1996; JÜTTEMANN & THOMAE 1998; FAHRENBERG 2002). [5]

Die Folge dieses Versäumnisses ist, dass der Umgang mit unstrukturierten Daten, Beobachtungen und Texten weniger systematisch erfolgt als der Umgang mit skalierten Variablen. So zeigen die Rückmeldungen vieler Teilnehmer/innen des 8. Magdeburger Methoden-Workshops und die Diskussionen in der Mailingliste Qualitative Sozialforschung (QSF-L) zum Thema "Grounded Theory" (beides im Januar 2005), dass es ein ausgeprägtes Bedürfnis gibt, sich bei der Auswertung von qualitativen Daten an Regeln zu orientieren. Auch in meiner eigenen Betreuung von Qualifizierungsarbeiten stellt sich der Umgang mit gesammelten und transkribierten Interviewdaten häufig als die größte Hürde im gesamten Forschungsprozess heraus. Man steht vor einer großen Menge unstrukturierter Daten, weiß nicht wo anzufangen und wie Ordnung herzustellen ist. [6]

Eine Professionalisierung im Umgang mit qualitativen Daten wäre also wünschenswert. BERGMANN und COXON (2005) schlagen z.B. für die Schweiz ein nationales Forschungszentrum vor, das Forschung, Beratung, Lehre und Information zu qualitativer Forschung bündeln sollte. Auch sie betonen die zentrale Rolle der Ausbildung für die Sicherung von Qualitätsstandards. Ausführliche Arbeiten zu Gütekriterien qualitativer Verfahren liegen inzwischen vor (GUBA & LINCOLN 1989; SEALE 1999; STEINKE 1999; FLICK 2004 sowie die laufend in FQS geführte Debatte zu Qualitätsstandards qualitativer Sozialforschung). [7]

Aus bildungswissenschaftlicher Perspektive kommt zur Gegenstandsangemessenheit einer Methode (appropriateness of method, BRUSCIA 2005) noch ein weiteres Gütekriterium hinzu. Die reflexive und methodisch kontrollierte Beschäftigung mit kulturellen und sozialen Voraussetzungen des menschlichen Handelns dient zu deren Verständnis und Verbesserung. Sozialforschung intendiert immer auch gemeinschaftliche Lern- und Entwicklungsprozesse. Reflexion wird aber gerade durch die Anwendung systematischer Beobachtungsmethoden gefördert. Folglich ist die Aneignung methodischer Prinzipien durch die beforschten Akteure durchaus wünschenswert, denn nur so kann das Verständnis für die durch das Verfahren vollzogenen Transformationen von Wahrnehmungen und Daten ermöglicht werden. Dies wiederum erhöht die Akzeptanz und damit die Geltung der Befunde im beforschten Feld. Die Kooperationsförderlichkeit von Methoden ist damit ebenfalls ein zentrales Gütekriterium für Sozialforschung insgesamt, besonders aber für ihren qualitativen Zweig (ähnlich: interpersonal integrity, BRUSCIA 2005). [8]

2. Das Repertory-Grid-Interview als kooperative Forschungsmethode

Häufig genug jedoch spielen sich auch die wesentlichen Operationen und Auswertungsschritte qualitativer Verfahren ohne Beteiligung der Beforschten ab. Meist werden Texte aufgezeichnet und jenseits des Feldes transkribiert und ausgewertet. Daran ändert auch der sich anschließende Prozess der dialogischen Validierung nichts, wenn diese überhaupt systematisch vollzogen wird. [9]

Der Rückgriff auf die Grounded Theory oder die qualitative Inhaltsanalyse kann in einer solchen Situation kaum Orientierung schaffen, da diese eher eine allgemeine Strategie im Umgang mit Daten beschreiben als konkrete Anhaltspunkte oder Entscheidungshilfen zu ihrer Verarbeitung bereit zu stellen. Sie geben grundsätzliche Kriterien im Umgang mit Daten vor, etwa, dass jede Aussage auf Datenbasis begründbar sein sollte, oder dass so lange neue Fälle zur Auswertung hinzugezogen werden, bis sich die Resultate als stabil erweisen. Sie geben auch technische Hinweise für den Forschungsprozess, etwa wie man Memos schreibt, Codierungen vornimmt oder Kategorien bildet. Sie formulieren aber keine Regeln für die einzelnen Transformationen zwischen dem Originaldatum und dem späteren Ergebnis des Forschungsprozesses. Den Forschungsakteuren bleibt ein großer Spielraum. [10]

Methoden, die den Erkenntnisprozess regelgeleitet vollziehen, ermöglichen vom Feldzugang über die Erhebung bis in die Auswertung und Aufbereitung der Daten ein konsistentes und transparentes Vorgehen. Die einzelnen Schritte greifen begründet und transparent ineinander. Das im qualitativen Bereich wohl am häufigsten eingesetzte Beispiel hierfür ist das narrative Interview, insbesondere in seiner Spezialisierung als autobiographische Stegreiferzählung. Phänomenologisch und linguistisch fundiert nutzt es die Erzählung als die der Erfahrung am nächsten stehende verbale Darstellungsform. Für die Auswertung eines narrativen Textes wird eine bestimmte Schrittfolge (Sequenzierung, formale Analyse, analytische Abstraktion, ggf. biographische Gesamtformung) vorgegeben, für die einzelnen Schritte stehen formale Kriterien und Kategorien zur Entscheidungsfindung zur Verfügung. [11]

In der Psychologie sind ebenfalls qualitative Verfahren entwickelt worden, die Erhebung und Auswertung detailliert nachvollziehbar beschreiben – etwa Strukturlegetechniken (SCHEELE & GROEBEN 1988), die Imagination und Introspektion (LAZARUS 1980; KLEINING & WITT 2000) oder die psychoanalytisch geprägte Hermeneutik (LEITHÄUSER & VOLMERG 1979). Deren stärkere Verbreitung scheitert nicht nur an der Ignoranz des psychologischen Kerncurriculums gegenüber qualitativen Verfahren, sondern auch daran, dass sich Pädagogik und Soziologie immer noch scheuen, offensiver auch diese Traditionen einzubinden. [12]

Diese Zurückhaltung gilt auch bisher für das Repertory-Grid-Interview. Dabei kommt die Psychologie persönlicher Konstrukte, die dem Verfahren zugrunde liegt, den genannten Gütekriterien entgegen (KELLY 1991): Ihr liegt daran, den Klient/Akteur mit seiner Sicht der Realität in einem gemeinsamen Konstruktionsprozess mit dem Therapeuten/Forscher ernst zu nehmen. Wie andere Konstruktivisten auch setzt George KELLY sich mit dem menschlichen Wahrnehmen und Denken auseinander und kommt zu dem Schluss, Menschen begegnen ihrer Umwelt vorausschauend, aktiv und experimentierend ("man the scientist", auch: "inquiring man"; Kap. 2 des besprochenen Bandes; vgl. BANNISTER & FRANSELLA 1981). Sie konstruieren ihre Umwelt aufgrund von Ähnlichkeiten und Unterschieden, die sie zwischen Erscheinungen und Gegenständen wahrnehmen. Demnach bildet jede Unterscheidung ein Konstrukt, jeder Mensch entwickelt ein einzigartiges Konstruktsystem. Konstrukte werden dichotom konstruiert, nicht aber in gleichabständigen Intervallen. [13]

Das Repertory-Grid-Interview ist ein Versuch, diese Konstrukte einer Person zu entdecken, zu verbalisieren und in Beziehung zueinander und zum in Frage stehenden Untersuchungsgegenstand zu setzen (eine illustrierte Darstellung erfolgt bei der Besprechung der Software in Abschnitt 4.1 und 4.2). Da Konstrukte erfahrungsbasiert sind, können sie sich verändern. Auch ein solcher Veränderungs- oder Lernprozess kann und soll mit dem Repertory-Grid sichtbar gemacht werden. Denn eine weitere prägende Wurzel des Verfahrens ist KELLYs psychotherapeutische Tätigkeit: er setzte es in Interviews mit Klienten ein, um eine gemeinsame Sicht auf deren Selbstbild und soziale Beziehungen zu entwickeln sowie Entwicklungsziele und Entwicklungsrichtungen zu vereinbaren. Die von ihm entwickelte Urform des Interviews, der Role-Construct-Repertory-Test, diente also nicht dem distanzierten Blick des Forschers, sondern der gemeinsamen Arbeit zwischen Therapeut und Klient. Das Repertory-Grid-Interview ist keine Beobachtungsmethode, sondern eine Kooperationsmethode. [14]

Es ist zusätzlich wertvoll, weil es ähnlich wie die Strukturlegetechnik ein Verfahren ist, das nicht nur die Datenerhebung, sondern auch die Modellbildung im Dialog mit den Forschungspartnern vollzieht (RAEITHEL 1998). Feldaufzeichnungen, verbale Protokolle von Interviews oder Gruppendiskussionen werden als Transkripte von dem Forscher oder der Forscherin allein oder in der Forschungsgruppe ausgewertet. Selbst wenn das Erklärungsmodell als Ergebnis dieser Auswertung an die Akteure rückgekoppelt wird, so haben diese doch keinen direkten Einfluss auf dessen Entstehen. Kooperative Verfahren aber sollten nicht nur die selbst strukturierte Darstellung erlebter Wirklichkeit, sondern auch deren systematische Auslegung unterstützen. [15]

3. Eine Einführung in die professionelle Handhabung des Repertory-Grid-Interviews

Das rezensierte Buch ist eine Einführung in das Repertory-Grid-Interview, die sich vor allem den technischen und operativen Fragen entlang jedes einzelnen Schrittes des Verfahrens widmet. George KELLY hat das Verfahren in seinem bis heute nur teilweise ins Deutsche übersetzten Hauptwerk selbst ausführlich beschrieben. So ist FROMMs Lehrbuch, 1995 in deutscher Erstauflage erschienen, neben der weiterhin verfügbaren Einführung von SCHEER und CATINA (1993) die einzig vorliegende ausführliche Einführung in deutscher Sprache. Der besprochene Band ist die Übersetzung dieses Lehrbuchs ins Englische. Gliederung und Text wurden nahezu unverändert beibehalten, einige neuere Quellen wurden ergänzt. In englischer Sprache liegt ferner die empfehlenswerte Einführung von FRANSELLA, BELL und BANNISTER (2004) vor. [16]

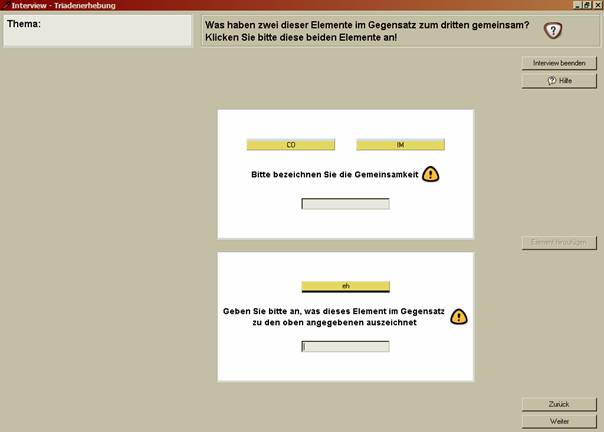

Der Band gibt zunächst eine kurze allgemeine Einführung in die Psychologie persönlicher Konstrukte, die die theoretische Basis für das vorgestellte Verfahren ist. Deren Verständnis ist wichtig, weil es eine hohe Korrespondenz zwischen theoretischer Grundlage und methodischer Durchführung gibt. Den Kern und mit etwa drei Vierteln auch größten Teil des Buches bildet die Darstellung der Interviewerhebung. Schritt für Schritt schildert FROMM das Vorgehen, diskutiert und begründet verschiedene Möglichkeiten der Datenerhebung, die in mehreren Stufen erfolgt. Methodische Weiterentwicklungen und Spielarten werden ebenfalls vorgestellt. Auf diese Weise liefert der Band Forschenden und Anwendern die Begründung für jede der im Verlauf einer Untersuchung zu treffenden methodischen Entscheidungen. Der Schwerpunkt liegt dabei auf der Frage der Interviewführung, die in der bisher vorliegenden Literatur zur Methode zu kurz kommt – und die letztlich auch die englische Neuauflage rechtfertigt. [17]

Im Repertory-Grid-Interview wird eine Matrix hervorgebracht, die die erarbeiteten Konstrukte der Auskunftsperson mit den ebenfalls gemeinsam beschriebenen Erfahrungselementen des in Frage stehenden Realitätsbereichs – dieses können z.B. Situationen (DICK 2000, 2001), Personen oder Gegenstände sein – in Beziehung setzt. Die Auswertung dieser Matrix wird in dem Buch ebenfalls behandelt. Sie sortiert sowohl die Elemente als auch die Konstrukte nach Ähnlichkeiten bzw. Unterschiedlichkeit, wodurch ein kohärenter persönlicher Begriffsraum entsteht. Bei FROMM dominiert die qualitative Strategie (gegenüber der quantitativen) und die "Handauswertung" (gegenüber der computergestützten Analyse), obwohl mit dem Repertory Grid qualitative wie quantitative Vorgehensweisen möglich sind. [18]

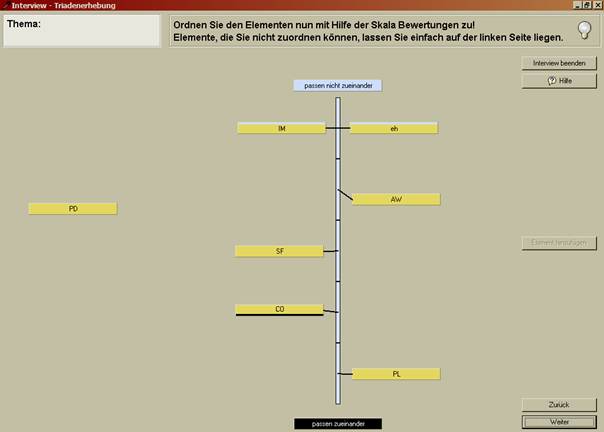

Insgesamt funktioniert dieses Buch wie ein Leitfaden. Die Hinweise zur praktischen Durchführung einer Untersuchung werden dabei immer wieder entlang der zugrunde liegenden Theorie der Persönlichen Konstrukte (vgl. Absatz 12) begründet – so zum Beispiel bei der Frage, ob Forschende Formulierungshilfen geben dürfen: "We are interested in bringing out the subject's own view not the experimenter/counsellor's" (S.78); oder bei der Entscheidung, ob die Auskunftsperson zwei, drei oder mehr Erfahrungselemente miteinander vergleichen sollte, um ein persönliches Konstrukt zu bilden: "The theoretical background for triadic presentation is Kelly's suggestion that we see personal constructs as a biploar distinction which establishes the similarity and difference between objects of experience at the same time" (S.72). [19]

Der Autor geht auf viele Aspekte der Interviewführung detailliert ein, die Praktikern immer wieder begegnen – seien es Schwierigkeiten in der Verbalisierung, die Gefahr der Wiederholung von Konstrukten o.a. – und gibt Hinweise, wie solchen Schwierigkeiten methodisch begegnet werden kann. In der Erhebung von Konstrukten, einem wesentlichen Schritt der Datenerhebung, unterscheidet er beispielsweise die Gegensatz- und die Unterschiedsmethode: Während ein Unterschied nur graduell ist (weiß – grau), ist der Gegensatz absolut, sodass die beiden benannten Pole sich ausschließen (weiß – schwarz). Hier präferiert FROMM die Formulierung von Gegensätzen, obwohl es auch gute Gründe für das Unterschiedsverfahren gibt (etwa wenn ein Gegensatz entlang der genannten Elemente nicht formuliert werden kann oder eine zu allgemeine Kategorie darstellt, etwa schwarz – nicht schwarz). [20]

In all seinen Hinweisen vermeidet FROMM orthodoxe Vorgaben, sondern überträgt es den Forschenden, entlang ihrer jeweiligen Ziele und Kontexte ihre methodischen Entscheidungen zu begründen. Der Band ist ein gelungenes Beispiel dafür, dass detaillierte operative Hinweise in methodischen Leitfäden gelingen, ohne dabei die Offenheit des Vorgehens zu gefährden. [21]

Der Frage, ob und wie man aus geschriebenen Texten (z.B. Selbstberichte, Interviewtranskripte) persönliche Konstrukte generieren kann, ist ebenfalls ein Kapitel gewidmet. Es wird darauf hingewiesen, dass in Texten Erfahrungselemente und Konstrukte nicht immer klar voneinander unterschieden werden können, und dass Konstrukte in Texten meist nur unipolar (und nicht dichotom) vorkommen. Zusammenfassend lässt sich auf dieser Basis sagen, dass Auswertungen von Texten als Bestandteil einer Untersuchung – etwa zur Vorbereitung oder Validierung – einen Stellenwert haben können, aber noch nicht so weit untersucht und beschrieben wurden, dass sie als eigenständiges Verfahren gelten könnten. [22]

Vor- und Nachteile der computergestützten Erhebung werden diskutiert, die gängigsten Verfahren (s. Abschnitt 3) dazu vorgestellt. FROMM unterscheidet Verfahren, die lediglich eine standardisierte Abfragemaske stellen, von solchen, die dem Nutzer und der Nutzerin viele Freiheitsgrade lassen. Selbstverständlich hängt es vom Einsatzszenario ab, welche Varianten gewählt werden. Es gilt allerdings zu berücksichtigen, dass mit der Erhebung von Repertory-Grids immer eine Kooperation und die Verständnisbasis zwischen Interviewer und Auskunftsperson unterstützt werden sollte. [23]

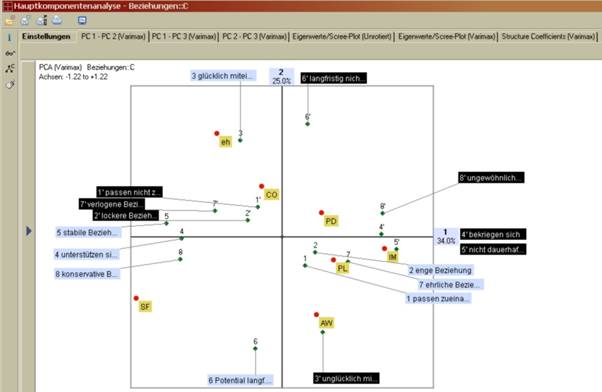

Ein weiterer Verdienst des Bandes ist, dass Alternativen, Weiterentwicklungen und spezielle Anwendungen des Repertory-Grids vorgestellt werden. Bei der Repertory-Grid-Interaction-Technique (RIT) etwa wird die Erhebung von Elementen und Konstrukten mit zwei Auskunftspersonen gleichzeitig durchgeführt. Ziel ist es dabei, dass die beiden Beteiligten ihre persönlichen Konstrukte und Sichtweisen wechselseitig besser verstehen lernen. Sie sind gehalten, während der verschiedenen Interviewphasen einander Fragen zu stellen und einander ihre Erfahrungen und Konstrukte zu erläutern. Andere Gruppentechniken wie "Misunderstood" oder "Let's just say" erweitern das Setting zur strukturierten Gruppenarbeit, indem spielerische Elemente und Verfahrensregeln eingeführt werden. [24]

Die Rolle des Interviewenden wird dabei anspruchsvoller, denn neben dem Hervorlocken von Elementen und Konstrukten muss zusätzlich die Verständigung zwischen den Beteiligten methodisch kontrolliert und sichergestellt werden. FROMM appelliert, diese Varianten des Verfahrens häufiger in Betracht zu ziehen und sich nicht auf die traditionelle Erhebungssituation zu beschränken. Eine Weiterentwicklung allerdings, die sich ganz in seinem Sinne explizit und ausführlich mit der Erhebung der Erfahrungselemente und mit der Heuristik zur Interpretation von Repertory-Grids befasst, das narrative Grid-Interview, wird hier nicht aufgegriffen, ist aber online verfügbar (DICK 2000, 2001). [25]

Insgesamt 31 hilfreiche Graphiken fassen die wichtigsten Schritte des Vorgehens zusammen, häufig als Flussdiagramme (z. B. course of a grid elicitation, S.42; laddering als Verfahren der Konstruktformulierung, S.94; u.v.m.). Allerdings sind die verschiedenen Ebenen der Überschriften schwer auseinander zu halten, da die Gliederung keine Ordnungsziffern enthält (in der deutschen Ausgabe ist die Gliederung zwar beziffert, aber auf einer Seite eng zusammengedrängt und ebenfalls nicht übersichtlich). Index und Abbildungsverzeichnis sind vorhanden. [26]

Fazit: Der Band stellt eine seriöse, gut verständliche und ausführliche Einführung in die Technik des Repertory-Grid-Interviews dar. Den Schwerpunkt legt der Autor auf die Interviewführung sowie die interpretativen und kooperativen Momente des Verfahrens. Es wird völlig zu Recht dessen qualitativer Charakter betont, der in Relation zum gesamten Erkenntnisbogen wesentlich zentraler ist als die mathematische Verrechnung der Matrix (die einer methodisch nicht sehr anspruchsvollen Clusteranalyse oder Hauptkomponentenanalyse folgt, vgl. Abschnitt 4.2 in dieser Besprechung). [27]

Was dem Band hingegen fehlt, ist der beispielhafte Blick auf empirische Untersuchungen, die mit dem Repertory-Grid-Interview durchgeführt wurden (ein Überblick findet sich in FRANSELLA 2003). Die Rationalität, mit der aus einem relevanten Problem eine wissenschaftliche Fragestellung und methodische Operationalisierung abgeleitet wird, kann eine solche Darstellung technischer Details nicht ersetzen. So bleibt es die Aufgabe des Lesers und der Leserin, das Verfahren sinnvoll in die Architektur eines Forschungsvorhabens einzubetten. Erst wenn diese methodische Entscheidung gefallen ist, lohnt der Griff zu diesem Buch. Es erleichtert dann aber alle nachgeordneten Entscheidungen erheblich. [28]

Übersichten über die verfügbare Software zur Erhebung und Auswertung von Repertory Grids finden sich sowohl am Ende des Buches von FROMM als auch in "Quantitative Methoden der Organisationsforschung" (MEYER & FREITAG 2005)1). Ein stichprobenartiger Test auf die Zugänglichkeit der Programme hat folgendes ergeben. [29]

RepGrid (Mildred SHAW, Brian GAINES) lässt sich als aktuelle Programmversion "Rep IV" problemlos herunterladen (5,9 MB; für persönliche Nutzung kostenlos, bis zu 15 Elemente und Konstrukte können verarbeitet werden), "WebGrid III", die kostenlose Webversion hiervon führt allerdings beim Versuch des Downloadens auf einen Broken Link (http://tiger.cpsc.ucalgary.ca/). Enquire Within aus Neuseeland bietet eine kostenlose, aber eingeschränkte Evaluierungslizenz: es können u.a. nur neun Konstrukte erhoben werden. Das Programm kann problemlos heruntergeladen werden (3,3 MB), die Darstellung im Netz ist sehr textlastig. Auch Idiogrid von James GRICE ist als eingeschränkt funktionale Testversion verfügbar (1,3 MB), auf der Homepage werden auch Screenshots dargestellt. [30]

Schwieriger zugänglich sind andere Programme. Auf DOS Basis und damit nicht für jedermann ohne Hilfe realisierbar laufen nach wie vor Richard BELLs "Gridstat" und "Gridscal" – die Reduzierung auf die mathematischen Operationen ist zwar für Puristen reizvoll, begibt sich aber der Möglichkeiten der Visualisierung, die das Repertory-Grid als Werkzeug eines kooperativen Forschungsprozesses so wertvoll machen. Die Spuren von GridLab, das Otto WALTER von der psychosomatischen Klinik an der Charité in Berlin mit viel Engagement programmiert hat, verlieren sich im World Wide Web leider mit dem Jahr 1999 (Zugriff 09.11.05). Weitere Informationen sind wohl nur über den Autor direkt zu erhalten. Über das viel zitierte Flexigrid des Norwegers Finn TSCHUDI lassen sich ebenfalls kaum Spuren finden, es existiert zwar eine Projektbeschreibung auf norwegisch aus dem Jahr 1998, eine Möglichkeit des Downloads oder eine Dokumentation von Anwendungen habe ich nicht entdeckt. Die Bezugsmöglichkeit direkt über den Autor wird jedoch auf den Seiten der PCP (Personal Construct Psychology) empfohlen (hier findet sich ebenfalls ein Überblick über verfügbare Software). [31]

Insgesamt liegt der Schwerpunkt der angebotenen Software auf der mathematischen Auswertung von Repertory-Grid-Interviews. Anders orientiert sich das elaborierte und vom Rezensenten ausführlich getestete "GridSuite". GridSuite ist eine Software zur Erhebung, Bearbeitung und Auswertung von Repertory-Grid-Interviews, die von Martin FROMM in Zusammenarbeit mit Andreas BACHER angeboten wird. Sie bietet Module für die gängigen Prozeduren eines Grid-Interviews von der Elementerhebung bis zur mathematischen und visualisierten Auswertung an. Wie das besprochene Buch legt auch die Software den Schwerpunkt auf die entdeckenden Potenziale dieser Forschungsmethode und begreift die Nutzenden als aktive Interpreten. Die mathematische Funktionalität bleibt auf das notwendigste beschränkt. Die Daten können in einem dialogischen Prozess mit der Auskunftsperson strukturiert und direkt eingegeben werden. [32]

GridSuite ist in Java programmiert und kann unter Windows und MacOS genutzt werden. Durch den XML-Datenstandard wird ein Datenaustausch mit anderen Programmen ermöglicht, zusätzliche Import-/Export-Optionen gestatten den Datenaustausch mit anderen Repertory-Grid-Programmen und SPSS. Die anschließende Besprechung des Programms erfolgt analog zum Erhebungs- und Auswertungsprozess. [33]

Die elektronische Erhebung eines Repertory-Grid-Interviews folgt einer selbsterklärenden Routine. Das Programm beginnt mit der Eingabe der Elementbezeichnungen, die den Erfahrungsraum der Auskunftsperson repräsentieren. In vorgegebene Textfelder brauchen lediglich die Bezeichnungen eingetippt werden (deren Ermittlung mit der Auskunftsperson allerdings im ausführlichen Dialog erfolgen sollte). [34]

Wenn die gewünschte Anzahl an Elementen erreicht ist, folgt der systematische Vergleich dieser Elemente untereinander. Der Auskunftsperson werden drei Elemente gezeigt, aus denen sie zwei heraussuchen soll, die einander ähneln, und die sich von dem dritten Element unterscheiden. Diese Ordnung wird anschließend durch Begriffe gekennzeichnet, sodass ein bipolares Konstrukt entsteht (Abbildung 1).

Abbildung 1: Der Triadenvergleich zwischen Elementen zur Erhebung von Konstrukten. Die Elemente sind in diesem Beispiel Abkürzungen, die für konkrete Personen stehen. [35]

Zwar wird immer wieder auch der Schritt zurück ermöglicht, trotzdem sollte darauf geachtet werden, dass diese Erhebung mit ausreichend Zeit und Sorgfalt durchgeführt wird, da Änderungen und Korrekturen die laufende Interviewsituation erheblich stören können. Ein Manko ist derzeit noch die Auswahl der drei vorgelegten Elemente: Unter den drei ausgewählten wird dasselbe Element in aufeinanderfolgenden Triaden all zu oft wiederholt, sodass die Bildung von Unterschieden und Gemeinsamkeiten zunehmend schwerer fällt. Hier wäre eine systematische Variation der Elemente zu empfehlen, die diese der Reihe nach in wechselnden Triadenkombinationen vorlegt. [36]

Nachdem ein Konstrukt gebildet wurde, werden alle Elemente zwischen seinen Polen eingeordnet. Hierzu legt das Programm eine intuitiv verständliche Analogskala vor. Die Elemente müssen mit der Maus je nach Bedeutung näher an den einen oder den anderen Pol des Konstruktes geschoben werden (Abbildung 2). Spielerisch und recht schnell wird so die Bewertungsmatrix ausgefüllt. Der Vorteil gegenüber einem nur an Zahlenwerten orientierten Rating ist, dass die Skalenwerte graphisch dargeboten sind und analog verstanden werden können. Diesen Schritt können die Auskunftspersonen ohne Instruktion und ohne Benutzung der Tastatur selber machen. Diese Routine wird so oft wiederholt, bis die gewünschte oder mögliche Anzahl an Konstrukten erhoben und bewertet wurde.

Abbildung 2: Das Rating der Elemente auf einem Konstrukt [37]

Einstellbar sind in diesem Modul des Programms die Anzahl der zu erhebenden Elemente bzw. Konstrukte (kann auch offen gelassen werden), die Art der Instruktion im Elementvergleich sowie die Anzahl der Skalenstufen für das Rating (voreingestellt sind 5 Stufen). Als Variante wird angeboten, eine Interviewvorlage zu erstellen, auf deren Basis dann mehrere Interviews mit gleichen Elementen und Konstrukten erhoben werden können. Dies erleichtert die interpersonelle Vergleichbarkeit. Unkompliziert ist auch die Eingabe der Daten eines auf Papier erhobenen Grids (eine Option, die der Rezensent gerne nutzt, ist doch das Papierverfahren in vielen Situationen nach wie vor "organischer" als die Verwendung von Laptops). [38]

Nach Beenden eines Interviews erscheint der Grid-Editor. Er stellt die komplette Matrix aus Elementen in den Spalten und Konstrukten in den Zeilen dar. Die Rating-Werte sind in Grau-Abstufungen übersetzt, können aber auch als Zahlen dargestellt werden (wie es in Abbildung 3 bei dem Konstruktpol "passen nicht zueinander" und dem Element "eh" gezeigt wird). Diese Darstellung wird als Bertin-Display bezeichnet (nach dem Kartographen Jacques BERTIN 1982). Das Besondere daran ist, dass durch die Farbkontraste sehr anschaulich wird, welche Ähnlichkeiten und Unterschiede zwei Elemente aufweisen, wenn man sie durch die Konstrukte beschreibt – und umgekehrt wie ähnlich sich die Konstrukte sind, wenn sie zur Deutung der Elemente angewendet werden. [39]

Auf dieser Ebene ist das Grid weiter bearbeitbar, man kann einzelne Konstrukte oder Elemente neu bewerten, vor allem aber mit der Methode der Handsortierung die Ähnlichkeiten und Unterschiede zwischen den Elementen oder den Konstrukten herausarbeiten. Dazu werden Zeilen bzw. Spalten markiert und können dann mit der Maus an eine andere Position in der Matrix bewegt werden. Diese Operation schult das Verständnis für die Relationen der Elemente und Konstrukte untereinander, wird durch GridSuite leicht gemacht und ist daher zu empfehlen.

Abbildung 3: Ungeordnete Bertin-Matrix eines Repertory-Grids mit markiertem Konstrukt [40]

Da die komplette Matrix mit Zahlen beschreibbar ist, lässt sie sich über mathematische Operationen weiter analysieren und visualisieren. GridSuite bietet hierzu die gängigen Verfahren der Clusteranalyse und Hauptkomponentenanalyse. Wichtig ist die Möglichkeit, verschiedene statistische Kennzahlen anzeigen zu lassen. Die Clusteranalyse beinhaltet die graphische Darstellung des Dendogramms und verschiedene Kennwerte (Matching-, Ähnlichkeits- und z-Werte, Ähnlichkeitsmatrix mit Zentralitätswerten für Elemente und Konstrukte). Ein beigefügtes elektronisches Handbuch erläutert diese Optionen kontextsensitiv. Verweise auf Quellen sind ebenfalls genannt, wobei FROMM sich hier vor allem auf die Originalarbeiten zur Eigenstrukturanalyse von SLATER (1977) und auf das Auswertungsprogramm von TSCHUDI (Flexigrid 6.0, Oslo 1998, s.o.) bezieht. [41]

Bei der Anwendung einer Hauptkomponentenanalyse erlaubt es GridSuite, die gewünschten Auswertungsroutinen optional zu wählen und darstellen zu lassen: die Anzahl der zu extrahierenden Komponenten, die Rotation der Hauptkomponenten oder die auszugebenden statistischen Kennziffern (Eigenwerte der rotierten und unrotierten Hauptkomponenten, verschiedene Koeffizienten für die Ähnlichkeit zwischen Konstrukten, zwischen Elementen sowie zwischen diesen und den Hauptkomponenten). [42]

Im Beispiel der Abbildung 4 etwa wurden drei Hauptkomponenten mit Varimax-Rotation berechnet, die erste erklärt 34 Prozent der Varianz, die zweite weitere 25 Prozent (für die Abbildung wurden Zufallsdaten eingegeben). Als Registerkarte können in diesem Fall angezeigt werden: die Koordinatensysteme (auch als Slater's Biplot bezeichnet) mit der ersten und zweiten, der ersten und dritten oder der zweiten und dritten Hauptkomponente, Tabellen mit den rotierten und unrotierten Eigenwerten der Komponenten (Screeplot) sowie die Korrelationen der Konstrukte mit den Komponenten (Structure Coefficients). Eine Korrelationsmatrix der Konstrukte untereinander wäre ebenfalls möglich. Das Koordinatensystem zeigt alle Elemente und Konstrukte und deren Lage im Raum, die ihre Ähnlichkeiten repräsentiert. Die Beschriftungen können geändert und von Hand bewegt werden.

Abbildung 4: graphische Darstellung der zwei Hauptkomponenten eines Repertory-Grids [43]

Eine besondere Variante bietet GridSuite für den Vergleich verschiedener Repertory-Grids untereinander. Die Shared-Grids-Option erlaubt es, mehrere Einzel-Grids miteinander auf Ähnlichkeit und Unterschiedlichkeit zu vergleichen, sofern diese die gleichen Elemente und Konstrukte enthalten. Dabei wird kein gemeinsamer Konstruktraum erzeugt, sondern es wird analysiert, welche Konstrukte und Elemente von den verschiedenen Auskunftspersonen mit hoher Ähnlichkeit bzw. hoher Streuung bewertet wurden. [44]

Insgesamt also bietet das Programm eine anschauliche und gut verständliche Prozedur zur Erhebung und Auswertung von Repertory-Grid-Interviews. Das gesamte Vorgehen wird dadurch erheblich erleichtert, dass die Erhebung, die mathematische Auswertung und die Visualisierung optimal aufeinander abgestimmt sind. Der Balanceakt zwischen leichter Bedienbarkeit (also automatisierten Routinen) und Adaptationsmöglichkeiten für den Nutzer und die Nutzerin (also von Hand einstellbaren Optionen) ist mit GridSuite gelungen. Es erlaubt eine aktive Aneignung der verschiedenen Operationsschritte und unterstützt dadurch auch das Erlernen der Methode – wie es auch das rezensierte Lehrbuch tut. [45]

In Kombination mit Projektionstechnologie (Beamer, Leinwand) werden interessante Optionen für die Arbeit in und mit Gruppen an Repertory-Grids eröffnet. Insbesondere interaktive Whiteboards erlauben es, die Erhebung, den Elementvergleich und Handsortierungen bei der Auswertung direkt und sinnlich erfahrbar durch die Akteure selbst vornehmen zu lassen. Die dabei erzielte Anschaulichkeit und Interaktivität erleichtert das Verständnis für die verschiedenen Transformationsschritte im Repertory-Grid-Interview. In der Forschung wird so die dialogische Validierung mit den Auskunftspersonen oder die Rückmeldung der Befunde in das Untersuchungssystem zu Interventionszwecken erleichtert. Das Verfahren lässt sich mithilfe des Programms gut in einen Forschungsprozess einbetten. Voraussetzung hierfür ist eine Strukturierung des untersuchten Interaktionsfeldes möglichst aus der Sicht der Handelnden. [46]

Insgesamt werden mit Buch und PC-Programm die technischen und operativen Voraussetzungen für die Erhebung von Repertory-Grid-Interviews in qualitativ angelegten Studien in ausreichender Breite geschaffen. Es ist gerade die beschriebene Anschaulichkeit und Leichtigkeit in der Durchführung, die das PC-Programm so geeignet für kooperativ angelegte Forschungsarbeiten erscheinen lassen. Der Intention des Urhebers KELLY, der seinen Klienten und Klientinnen in schwierigen Situationen Entwicklungswege und Lösungsmöglichkeiten aufzeigen wollte, wird dadurch eher entsprochen als durch Programme, die sich der "Tüftelei" an mathematischen Verfeinerungen widmen. Für seine Kooperationsförderlichkeit erhält GridSuite ein "sehr gut". [47]

Im Hinblick auf die Professionalität der Forschenden ist vor allem das besprochene Lehrbuch wertvoll. Es erläutert die zahlreichen einzelnen Schritte im Verlaufe der Erhebung und Auswertung eines Repertory-Grid-Interviews in der nötigen Offenheit, gleichzeitig aber theoretisch begründet. Das Buch ermöglicht es, sich das Verfahren komplett anzueignen, insbesondere die Erhebungsphase. [48]

Durch die Explikation und Begründung von Anwendungsregeln und -routinen tragen Buch und Programm zur Professionalisierung der Psychologie persönlicher Konstrukte und der aus ihr hervorgehenden Repertory-Grid-Methodik bei. Es werden erstmals Standards für das Repertory-Grid-Interview gesetzt, die nicht nur dessen statistische, sondern auch dessen heuristische Qualität beschreiben. Die Fruchtbarkeit dieser Standards hängt jedoch davon ab, in welchem Ausmaß es gelingt, das Repertory-Grid-Interview in konkreten Forschungsvorhaben im Feld zu kultivieren und sein unverwechselbares Erkenntnispotenzial entlang begründeter und intelligenter Fragestellungen zu entfalten. [49]

1) Die Einordnung des Repertory-Grid-Interviews als quantitatives Verfahren ist missverständlich, handelt es sich doch um ein am Einzelfall orientiertes Verfahren. Allerdings ist die Unterscheidung "quantitativ" und "qualitativ" bei näherem Hinsehen weder trennscharf noch treffend zur Charakterisierung von Forschungsmethoden (vgl. die Beiträge von KROMREY, SCHREIER oder REICHERTZ während des Symposiums "Qualitative und quantitative Methoden in der Sozialforschung: Differenz und/oder Einheit?" auf dem 1. Berliner Methodenreffen Qualitative Forschung; verfügbar unter: http://www.berliner-methodentreffen.de/material/2005/materialien_2005.php [Zugriff 16.11.05]. <zurück>

Bannister, Don & Fransella, Fay (1981). Der Mensch als Forscher (Inquiring Man). Die Psychologie der persönlichen Konstrukte. Münster: Aschendorff.

Bergman, Manfred Max & Coxon, Anthony P.M. (2005, Mai). The quality in qualitative methods (54 Absätze). Forum Qualitative Sozialforschung / Forum: Qualitative Social Research [Online Journal], 6(2), Art. 34. Verfügbar über: http://www.qualitative-research.net/fqs-texte/2-05/05-2-34-e.htm [Zugriff 02.12.05].

Bertin, Jacques (1982). Graphische Darstellungen. Berlin: de Gruyter.

Blumer, Herbert (1980). Der methodologische Standort des symbolischen Interaktionismus. In Arbeitsgruppe Bielefelder Soziologen (Hrsg.), Alltagswissen, Interaktion und gesellschaftliche Wirklichkeit (S.80-146). Opladen: Westdeutscher Verlag.

Bortz, Jürgen (2005). Statistik für Human- und Sozialwissenschaftler (6. Aufl.). Heidelberg: Springer.

Bortz, Jürgen & Döring, Nicola (2002). Forschungsmethoden und Evaluation für Human- und Sozialwissenschaftler (3. überarb. Aufl.). Berlin: Springer.

Bortz, Jürgen & Lienert, Gustav (2003). Kurzgefasste Statistik für die klinische Forschung: Leitfaden für die verteilungsfreie Analyse kleiner Stichproben. Berlin: Springer.

Breuer, Franz (1996). Qualitative Psychologie: Grundlagen, Methoden und Anwendungen eines Forschungsstils. Opladen: Westdeutscher Verlag.

Bruscia, Kenneth E. (2005). Standards of integrity for qualitative music therapy research. Voices. A World Forum for Music Therapy, 5(3), Art. 197. Verfügbar über: http://www.voices.no/mainissues/mi40005000197.html [Zugriff 02.12.05]. (Orig.: 1998, Journal of Music Therapy, XXX (3), 176-200)

Dick, Michael (1996). Zur Notwendigkeit und Methodologie prozessual verstandener Sozialforschung – am Beispiel der Erforschung zwischenbetrieblicher Kooperation. Hamburg: Harburger Beiträge zur Psychologie und Soziologie der Arbeit Nr. 13. Verfügbar über: http://psydok.sulb.uni-saarland.de/portal/hamburg_harburg/ [Zugriff am 18.11.05].

Dick, Michael (2000, Juni). Die Anwendung narrativer Gridinterviews in der psychologischen Mobilitätsforschung [39 Absätze]. Forum Qualitative Sozialforschung / Forum Qualitative Research [Online Journal], 1(2), Art. 6. Verfügbar über: http://www.qualitative-research.net/fqs-texte/2-00/2-00dick-d.htm [Zugriff am 03.12.03].

Dick, Michael (2001). Die Situation des Fahrens. Phänomenologische und ökologische Perspektiven der Psychologie. Hamburg: Harburger Beiträge zur Psychologie und Soziologie der Arbeit, Sonderband 3. Verfügbar über: http://psydok.sulb.uni-saarland.de/portal/hamburg_harburg/ [Zugriff am 18.11.05].

Fahrenberg, Jochen (2002). Psychologische Interpretation: Biographien – Texte – Tests. Bern: Huber.

Fidler, Fiona; Cumming, Geoff; Burgman, Mark & Thomason, Neil (2004). Statistical reform in medicine, psychology and ecology. The Journal of Socio-Economics, 33(5), 615-630.

Flick, Uwe (2004). Triangulation: eine Einführung. Wiesbaden: VS, Verlag für Sozialwissenschaften.

Fransella, Fay (Ed.) (2003). International handbook of personal construct psychology. Chichester: Wiley.

Fransella, Fay; Bell, Richard & Bannister, Don (2004). A manual for repertory grid technique. Chichester: Wiley.

Gigerenzer, Gerd (2004). Mindless statistics. The Journal of Socio-Economics, 33(5), 587-606.

Glaser, Barney G. (1978). Theoretical sensitivity: Advances in the methodology of grounded theory. Mill Valley, CA: Sociology Press.

Glaser, Barney G. & Strauss, Anselm L. (1967). The discovery of grounded theory: Strategies for qualitative research. New York, NY: Aldine.

Graumann, Carl F. (1976). Die ökologische Fragestellung – 50 Jahre nach Hellpachs "Psychologie der Umwelt". In Gerhard Kaminski (Hrsg.), Umweltpsychologie. Perspektiven – Probleme – Praxis (S.21-25). Stuttgart: Ernst Klett Verlag.

Guba, Egon G. & Lincoln, Yvonna S. (1989). Fourth generation evaluation. Newbury Park: Sage.

Jäger, Reinhold S. (Hrsg.) (1988). Psychologische Diagnostik. Ein Lehrbuch. München: Psychologie Verlags Union.

Jüttemann, Gerd & Thomae, Hans (1998). Biographische Methoden in den Humanwissenschaften. Weinheim: Beltz / PVU.

Kaminski, Gerhard (1986). Zwischenbilanz einer "psychologischen Ökologie". In Gerhard Kaminski (Hrsg.), Ordnung und Variabilität im Alltagsgeschehen (S.9-29). Göttingen: Hogrefe.

Kelly, George A. (1991). The psychology of personal constructs. Vol 1: A theory of personality. London: Routledge. (Reprint, orig. publ. New York: Norton, 1955)

Keupp, Heiner (Hrsg.) (1993). Zugänge zum Subjekt: Perspektiven einer reflexiven Sozialpsychologie. Frankfurt/M.: Suhrkamp.

Kleining, Gerhard & Witt, Harald (2000). Qualitativ-heuristische Forschung als Entdeckungsmethodologie für Psychologie und Sozialwissenschaften. Die Wiederentdeckung der Methode der Introspektion als Beispiel [19 Paragraphen]. Forum Qualitative Sozialforschung / Forum Qualitative Research [Online Journal], 1(1), Art. 13. Verfügbar über: http://www.qualitative-research.net/fqs-texte/1-00/1-00kleiningwitt-d.htm [Zugriff 07.01.2003].

Lazarus, Arnold (1980). Innenbilder. Imagination in der Therapie und als Selbsthilfe. München: Pfeiffer.

Leithäuser, Thomas & Volmerg, Birgit (1979). Anleitung zur empirischen Hermeneutik. Psychoanalytische Textinterpretation als sozialwissenschaftliches Verfahren. Frankfurt/M.: Suhrkamp.

Lienert, Gustav & Raatz, Ulrich (1994). Testaufbau und Testanalyse (5. völlig neu bearbeitete und erweiterte Auflage). Weinheim: Beltz / PVU.

Metzger, Wolfgang (1941). Psychologie. Die Entwicklung ihrer Grundannahmen seit der Einführung des Experiments (2. Aufl. 1954). Darmstadt: Steinkopff.

Meyer, Matthias & Freitag, Matthias (2005). Quantitative Methoden der Organisationsforschung: Repertory Grid. Verfügbar über: http://www.qualitative-research.net/organizations/2/or-rg-d.htm [Zugriff 11.11.2005].

Mummendey, Hans Dieter (1995). Die Fragebogen-Methode. Grundlagen und Anwendung in Persönlichkeits-, Einstellungs- und Selbstkonzeptforschung. Göttingen: Hogrefe.

Petermann, Franz (1988). Idiographie und Nomothetik. In Reinhold S. Jäger (Hrsg.), Psychologische Diagnostik. Ein Lehrbuch (S.23-26). München: Psychologie Verlags Union.

Raeithel, Arne (1998). Kooperative Modellproduktion von Professionellen und Klienten – erläutert am Beispiel des Repertory Grid. In ders., Selbstorganisation, Kooperation, Zeichenprozess. Arbeiten zu einer kulturwissenschaftlichen, anwendungsbezogenen Psychologie (S.209-254). Opladen: Westdeutscher Verlag.

Scheele, Brigitte & Groeben, Norbert (1988). Dialog-Konsens-Methoden zur Rekonstruktion subjektiver Theorien: die Heidelberger Struktur-Lege-Technik (SLT, konsensuale Ziel-Mittel-Argumentation und kommunikative Flussdiagramm-Beschreibung von Handlungen. Tübingen: A. Francke Verlag.

Scheer, Jörn & Catina, Ana (Hrsg.) (1993). Einführung in die Repertory Grid-Technik. Band 1: Grundlagen und Methoden. Band 2: Klinische Forschung und Praxis. Bern: Huber.

Seale, Clive (1999). The quality of qualitative research. London: Sage.

Slater, Patrick (1977). The measurement of intrapersonal space by grid technique. Vol 2: Dimensions of intrapersonal space. London: Wiley.

Steinke, Ines (1999). Kriterien qualitativer Forschung. Ansätze zur Bewertung qualitativ-empirischer Sozialforschung. Weinheim: Juventa.

Thomae, Hans (1989). Zur Relation von qualitativen und quantitativen Strategien psychologischer Forschung. In Gerd Jüttemann (Hrsg.), Qualitative Forschung in der Psychologie. Grundfragen, Verfahren, Anwendungsfelder (S.92-107). Heidelberg: Asanger.

Thompson, Bruce (2004). The "significance" crisis in psychology and education. The Journal of Socio-Economics, 33(5), 607-613.

Michael DICK, Juniorprofessor; Arbeitsschwerpunkte: Wissen und Erfahrung in der Organisations- und Professionsentwicklung, interdisziplinäre Mobilitätsforschung, wissenschaftliche Weiterbildung.

Kontakt:

Prof. Dr. Michael Dick

Juniorprofessor für Erwachsenenbildung und Organisationsentwicklung

Institut für Erziehungswissenschaft

Otto-von-Guericke Universität Magdeburg

D-39016 Magdeburg

E-Mail: michael.dick@gse-w.uni-magdeburg.de

URL: http://www.uni-magdeburg.de/mpeb/dick/

Dick, Michael (2005). Das Repertory-Grid-Interview als Methode kooperativen Forschungshandelns. Review Essay: Martin Fromm (2004). Introduction to the Repertory Grid Interview / Martin Fromm & Andreas Bacher (2003-2004). GridSuite 2.1.0 (Software zur Erhebung, Bearbeitung und Auswertung von Repertory-Grid-Interviews) [49 Absätze]. Forum Qualitative Sozialforschung / Forum: Qualitative Social Research, 7(2), Art. 6, http://nbn-resolving.de/urn:nbn:de:0114-fqs060263.